| Linha 629: | Linha 629: | ||

* '''Conceito''' | * '''Conceito''' | ||

** A eXteme Programming (Programação Extrema, em Português), também conhecida como XP, é uma metodologia ágil aplicada como processo de desenvolvimento de softwares. É, majoritariamente, atribuída a equipes de pequeno e médio porte, que baseiam seu trabalho em requisitos vagos e que se modificam rapidamente. Como características conceituais, a XP traz consigo um foco desenvolvimentista em sistemas orientados a objeto e em enquadramento de projeto incremental (ou iterativo), no qual o sistema começa a ser implementado logo no início e vai ganhando novas funcionalidades ao longo do tempo. | ** A eXteme Programming (Programação Extrema, em Português), também conhecida como XP, é uma metodologia ágil aplicada como processo de desenvolvimento de softwares. É, majoritariamente, atribuída a equipes de pequeno e médio porte, que baseiam seu trabalho em requisitos vagos e que se modificam rapidamente. Como características conceituais, a XP traz consigo um foco desenvolvimentista em sistemas orientados a objeto e em enquadramento de projeto incremental (ou iterativo), no qual o sistema começa a ser implementado logo no início e vai ganhando novas funcionalidades ao longo do tempo. | ||

<br> | <br> | ||

| Linha 640: | Linha 641: | ||

***'''Colaboração com o cliente''' mais que negociação de contratos; | ***'''Colaboração com o cliente''' mais que negociação de contratos; | ||

***'''Responder a mudanças''' mais que seguir um plano. | ***'''Responder a mudanças''' mais que seguir um plano. | ||

<br> | |||

<br> | |||

| Linha 671: | Linha 674: | ||

consecutiva, existe um problema sério no projeto que deve ser resolvido não com aumento de horas trabalhadas, mas com melhor planejamento, por exemplo. | consecutiva, existe um problema sério no projeto que deve ser resolvido não com aumento de horas trabalhadas, mas com melhor planejamento, por exemplo. | ||

Fonte: TELES (2006) | Fonte: TELES (2006)/Comparação entre Metodologias Ágeis e Tradicionais para o Desenvolvimento de Software *[http://infocomp.dcc.ufla.br/index.php/INFOCOMP/article/view/68]-pdf disponível para download | ||

<br> | <br> | ||

| Linha 682: | Linha 686: | ||

***DSDM - Dynamic System Development Model - https://www.agilebusiness.org/ | ***DSDM - Dynamic System Development Model - https://www.agilebusiness.org/ | ||

***LSD - Lean Software Development - https://www.lean.org.br/o-que-e-lean.aspx | ***LSD - Lean Software Development - https://www.lean.org.br/o-que-e-lean.aspx | ||

<br> | <br> | ||

| Linha 688: | Linha 693: | ||

* '''Criadores''' | * '''Criadores''' | ||

** Em 1996, o programador e consultor em T.I, Kent Beck, idealizou e introduziu as primeiras primeiras práticas da eXtreme Programming, que eram frutos de anos de experiência e trabalho em métodos leves, ao lado de seu parceiro Ward Cunningham. Na ocasião, a empresa Chrysler solicitou os serviços de Beck, para unificar quatro sistemas de softwares legado, com 20 anos de uso. O trabalho era um tanto complicado, pois a função do sistema era controlar a folha de pagamento de quase 86 mil funcionários da empresa. Para atingir o objetivo, Kent não apenas avaliou e orientou diversas pessoas da grande equipe disponível, como distribuiu funções e dividiu, em pequenos grupos, o contingente de responsáveis pela tarefa, introduzindo, pela primeira vez, sua metodologia. No fim, com 14 meses de trabalho, o resultado foi um grande sucesso e a XP começou a ser adotada por diversos times de desenvolvimento pelo mundo. | ** Em 1996, o programador e consultor em T.I, Kent Beck, idealizou e introduziu as primeiras primeiras práticas da eXtreme Programming, que eram frutos de anos de experiência e trabalho em métodos leves, ao lado de seu parceiro Ward Cunningham. Na ocasião, a empresa Chrysler solicitou os serviços de Beck, para unificar quatro sistemas de softwares legado, com 20 anos de uso. O trabalho era um tanto complicado, pois a função do sistema era controlar a folha de pagamento de quase 86 mil funcionários da empresa. Para atingir o objetivo, Kent não apenas avaliou e orientou diversas pessoas da grande equipe disponível, como distribuiu funções e dividiu, em pequenos grupos, o contingente de responsáveis pela tarefa, introduzindo, pela primeira vez, sua metodologia. No fim, com 14 meses de trabalho, o resultado foi um grande sucesso e a XP começou a ser adotada por diversos times de desenvolvimento pelo mundo. | ||

<br> | <br> | ||

* '''Referências''' | * '''Referências''' | ||

Edição das 05h03min de 16 de abril de 2018

Agora que cada um já possui seu tema, acesse http://www.sourceinnovation.com.br/wiki/Template_Temas Avalie se seu tema se enquadra em Metodologia, Tecnologia ou Software e escolha um dos templates Utilizando basicamente Google Academic, Revistas, Livros ou sites de fornecedor, realize sua pesquisa e responda aos itens Seu conteúdo deve ser escrito abaixo do link no final da página. Exemplo: Algoritmos

| Tema | Aluno |

|---|---|

| Algoritmos | Vitor Manoel Gonçalves Teixeira |

| API | Paulo Reis dos Santos Junior |

| App | Carlos Augusto Dantas Marquez |

| Arduino | João Vitor Santos Izidoro |

| Banco de Dados | Otávio Augusto de Oliveira |

| Barramentos | Leonardo Henrique Rodrigues Montes |

| BI | Daniela |

| BigData | Vinícius Carvalho Cazarotti |

| BlockChain | Victor Hugo |

| CanvAs | Vinicius Stachechen Machado |

| Cloud Computing | Vitória Caroline de Paulo |

| CLP | Caio Rafael dos Santos |

| Compiladores | Mauricio Neto |

| Conectores | Marcel Felipe de Paiva Maciel |

| CPU | Marcus Vinicius Marchiori |

| Criptografia | Igor de Castro |

| Data Mining | Vinicius Calixto Rocha |

| DMA | Vinicius Alves Martins |

| ERP | Emerson Martins dos Santos |

| ETL | Gabriel Pires |

| eXtreme Programming | Gabriel Alcântara da Costa Batista |

| Firewall | Caio Marcio |

| Firmware | Agilson Jr |

| Frameworks | Paulo Victor Silva Mello |

| IA | Estela Rezende Goulart |

| IDE | Matheus Ferreira Riguette de Souza |

| Inteligência Cognitiva | Bruno Henrique Rodrigues dos Reis |

| Integração Contínua | Joao Victor Johanson |

| IoT | Helton Pereira de Aguiar |

| IPSec | Hugo Borges Oliveira |

| Linguagens de Programação | Frederico Marques Fulgêncio |

| Machine Learning | Diego Batistuta Ribeiro de Andrade |

| Memória RAM | Railson da Silva Martins |

| Mineração de Dados | Murilo |

| Modelo Estruturado | Gabriel Victor Duarte Pereira |

| Modelo Orientado a Objeto | Guilherme Bartasson Naves Junker |

| Modem | Klesley Silva de Oliveira |

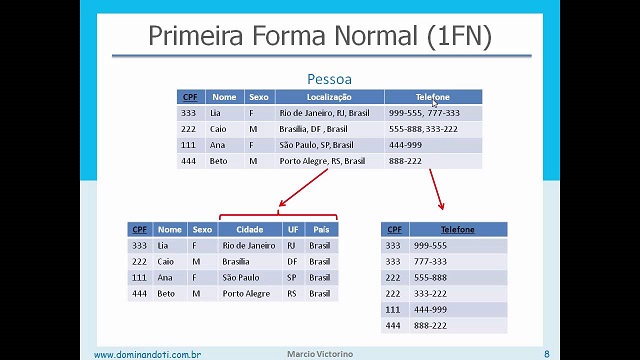

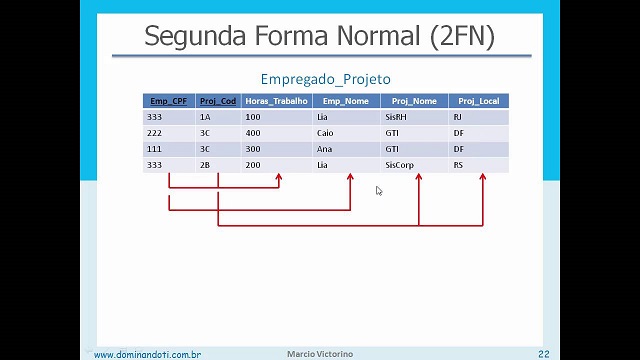

| Normalização (BD) | Estevão |

| NoSQL | César Ricardo Salomão Junior |

| Open Source | Guilherme Daisuke |

| Plataformas | Alexandre Mariano |

| Processadores | Nicolas de Melo Proença |

| Portas | Matheus Candido Ferreira de Faria |

| Protocolos | Gabriel Dal Belo Gomes Santos |

| PWA | Heldson Luiz da Silva |

| RA | Luiz Fellipe Silva Lima |

| Raspberry | Henrique Tornelli Duarte |

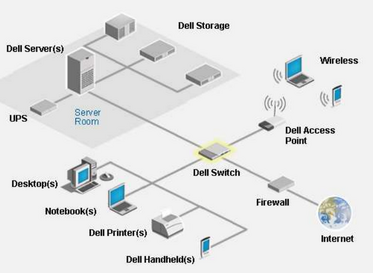

| Redes de Computadores | Victor Silva Santos |

| Redes Neurais | Matheus Fagundes |

| Renderização | Pedro Eduardo |

| Roteador | Matheus Negrisolli Rosa Seixas |

| Satélite | Fernando Toshiharu |

| Scrum | Artur Amaro |

| Sistema embarcado | Pedro Henrique Silva Medeiros |

| SO | Gabriel Hernandes de Oliveira Bogás |

| Sockets | Eduardo Silvestre Gonçalves |

| Speech Recognition | Gabriel Vieira |

| SQL | Max Pereira Ziller |

| Virtualização | Vitor Hugo Celio Machado |

| Web | Isaque dos Reis |

| Webservice | Wallyson Pedrosa Ferreira |

Pesquisa dos temas

Algoritmos

- Conceito:

- Algoritmo é um termo antigo que vem do nome do matemático iraniano al-Khwārizmī, que teve grande influência no crescimento da ciência. O conceito mais abrangente da palavra é “uma sequência de ações a serem feitas para resolver um problema ou atingir um objetivo”, e essa tecnologia já era usada até mesmo pelos antigos filósofos gregos, como Euclides e Erastóstenes. Existem vários tipos de algoritmos, e esses podem ser implementados por humanos, computadores e robôs: humanos podem criar a lista de ações(o algoritmo em si) e, dependendo do tipo de ações requisitadas, ele mesmo ou outras pessoas podem seguir esses passos, ou atribuí-los ao computador, escrevendo um programa com base na lista. Existem também métodos de representação de algoritmos, com regras específicas para que a pessoa, robô ou computador(após o código ter sido escrito e compilado) possa interpretar claramente os passos a serem seguidos, pois a linguagem natural humana permite múltiplas interpretações diferentes para cada frase, e isso pode comprometer o cumprimento do objetivo. Na computação, as representações de algoritmo mais utilizadas são os fluxogramas e o pseudocódigo;

- Fluxograma:

- Pseudocódigo:

- Para que serve um algoritmo e como ele pode ser usado?

- O algoritmo básico, escrito como uma simples lista de tarefas que um humano é capaz de fazer, para cumprir determinado objetivo, como “fazer um bolo”, serve para organizar e ordenar o que deve ser feito para cumprir tal objetivo, além de direcionar a pessoa que deseja cumprí-lo. Para problemas ou objetivos mais complexos, como detalhar um plano para expansão de uma empresa ou negócio por meio de ações e, comumente são usados fluxogramas e gráficos para estabelecer o que deve ser feito.

- Na computação, o algoritmo também pode ser tratado em formas diferentes: como já foi citado, os fluxogramas e o pseudocódigo são métodos de representação de algoritmos, que são usados principalmente nas primeiras etapas de desenvolvimento de um software antes de sua codificação. Servem como uma “planta” para que o programador analise e se direcione, assim tendo mais facilidade no cumprimento de sua tarefa, que, em vez de simplesmente codificar sem referência ou certeza do que deve ser feito e como deve ser feito, irá converter essas representações diretamente para uma das linguagens de programação. Não só isso: todo software é, essencialmente, um algoritmo.

- Algoritmo é um termo antigo que vem do nome do matemático iraniano al-Khwārizmī, que teve grande influência no crescimento da ciência. O conceito mais abrangente da palavra é “uma sequência de ações a serem feitas para resolver um problema ou atingir um objetivo”, e essa tecnologia já era usada até mesmo pelos antigos filósofos gregos, como Euclides e Erastóstenes. Existem vários tipos de algoritmos, e esses podem ser implementados por humanos, computadores e robôs: humanos podem criar a lista de ações(o algoritmo em si) e, dependendo do tipo de ações requisitadas, ele mesmo ou outras pessoas podem seguir esses passos, ou atribuí-los ao computador, escrevendo um programa com base na lista. Existem também métodos de representação de algoritmos, com regras específicas para que a pessoa, robô ou computador(após o código ter sido escrito e compilado) possa interpretar claramente os passos a serem seguidos, pois a linguagem natural humana permite múltiplas interpretações diferentes para cada frase, e isso pode comprometer o cumprimento do objetivo. Na computação, as representações de algoritmo mais utilizadas são os fluxogramas e o pseudocódigo;

- Funcionamento:

- Descreva aqui o funcionamento, as técnicas e detalhes desta tecnologia

- Estado da Arte::

- Cite o estágio mais atual desta tecnologia, ou seja, exemplos de aplicações bem recentes

- Integrações:

- Informe aqui com que outras tecnologias esta depende ou interage

API

- Conceito:

- API's (Application Programming Interface, ou em Português, Interface de Programação de Aplicações) trata-se de um conjunto de rotinas (partes de códigos feitos para resolver problemas muito específicos) e padrões preestabelecidos por um software que permitem a utilização de parte de suas funcionalidades dentro de outro sistema. Basicamente, funciona como "ponte" entre diferentes aplicações, enviando e recebendo dados de um sistema a outro.

- Esta tecnologia tem grande utilidade, pois:

- Permite que sistemas criados utilizando tecnologias diferentes comuniquem-se sem que seja necessário se adequar ao sistema que deseja utilizar em sua aplicação.

- Reduzem o tamanho de aplicações, pois com a manipulação específica de dados de uma API, o sistema não necessita ser ocupado com dados desnecessários.

- Trazem grande segurança aos dados, já que apenas uma certa informação será disponibilizada pela empresa que gera certa API de seu sistema.

- Permitem a monetização por acesso (por exemplo, Netflix, que dispõe seu acervo apenas a seus assinantes.)

- Informam sobre quem acessou, quando acessou, de onde acessou e o que acessou. Isso permite melhorias no sistema, já que há uma visão detalhada do fluxo de dados.

- Um grande exemplo de API é o Google Maps, o qual é utilizado dentro de muitas aplicações para geolocalização e afins em sites de hotéis. Um exemplo de API local, é a requisição de data do sistema pelo Excel (quando se utiliza CTRL+;)

- Funcionamento:

- Uma API, como citado, é um conjunto de rotinas e padrões que permitem que funcionalidades de um software sejam acessadas por outro, como por exemplo o login por Facebook. Uma API é gerada quando uma empresa proprietária de determinado sistema deseja disponibilizar partes de suas funcionalidades a outros sistemas.O trabalho feito pela API é o de enviar ao servidor ao qual se refere (por exemplo, o servidor do Facebook) a solicitação feita pelo usuário. Após isso, a API recebe os dados que foram requisitados e os retorna ao cliente, ou usuário. Esse dado pode ser algum tipo de confirmação de login ou permissão para acesso, por exemplo.

- Utilizando-se de analogias, API's são como garçons que recebem o pedido dos fregueses (usuário) e o transmitem para o cozinheiro (servidor), retornando o alimento que foi solicitado (dados).

- Estado da Arte::

- APIs atualmente conseguem até mesmo prover inteligências artificiais. Podemos citar o Projeto Oxford, da Microsoft, que provém uma série de serviços de Inteligencia Artificial, como Computer Vision, reconhecimento facial, reconhecimento de emoções, text to speech, comandos por voz, spelling check. Outra API que provê serviços de inteligência artificial é a IBM Watson, que possui um sistema de machine learning tão poderoso que conseguiu vencer até mesmo campeões mundiais de xadrez utilizando-se das lições aprendidas.

- Integrações:

- API's são adicionais que podemos utilizar em nossos sistemas. A mesma já é gerada com o objetivo de ser inserida em outro sistema, portanto, depende completamente destes, seja em Web ou local. Inserida em outro sistema, a mesma depende do servidor de origem para coleta de dados e geração de informação. API's podem utilizar-se também do hardware do dispositivo onde está o sistema para realizar certas tarefas, dependendo de sua utilidade e objetivo.

- Referências Bibliográficas:

- https://vertigo.com.br/o-que-e-api-entenda-de-uma-maneira-simples/

- https://pt.wikipedia.org/wiki/Interface_de_programa%C3%A7%C3%A3o_de_aplica%C3%A7%C3%B5es

- https://sensedia.com/blog/apis/o-que-sao-apis-parte-2-como-uma-api-funciona/

- https://canaltech.com.br/software/o-que-e-api/

- https://www.tecmundo.com.br/programacao/1807-o-que-e-api-.htm

- https://becode.com.br/framework-biblioteca-api-entenda-as-diferencas/

- https://sensedia.com/blog/apis/apis-inteligencia-artificial/

App

Arduino

- Conceito:

- Explique aqui o que é esta tecnologia, para que serve e como pode ser usada

- Funcionamento:

- Descreva aqui o funcionamento, as técnicas e detalhes desta tecnologia

- Estado da Arte::

- Cite o estágio mais atual desta tecnologia, ou seja, exemplos de aplicações bem recentes

- Integrações:

- Informe aqui com que outras tecnologias esta depende ou interage

Banco de Dados

- Conceito:

- Bancos de dados são conjuntos de informações (agrupamento de dados organizado de modo que crie um sentido e conhecimento) que se relacionam entre si criando um sentido,semelhante a um armário com gavetas, nas quais estão guardadas pastas contendo diversas informações que de alguma forma se relacionam, esta comparação era o modo o qual empresas e organizações armazenavam suas informações, um modo físico (papel) e pouco eficiente, visto que, com um grande número de informações organizadas deste modo, poderia levar um tempo significativo para encontrar uma específica.

- Sua principal função é a de armazenar informações de forma eficiente e digital,possibilitando maior velocidade e eficiência em pesquisas, estudos ou em uso empresarial (garantindo uma melhor comunicação entre as diversas áreas de uma empresa por exemplo), podendo ser usado para gerenciar os bens de uma empresa, informações sobre clientes, informações necessárias para o funcionamento de uma aplicação.

- Funcionamento:

- Sendo operados por um SGBD (Sistema de Gerenciamento de Dados), o qual é um conjunto de softwares que tem como responsabilidade o gerenciamento de um banco de dados,exixstem dois tipos de bancos de dados: os bancos de dados relacionais (que utilizam SQL) e os NoSQL.

- Os bancos de dados relacionais (que utilizam SQL) já estão consolidados no mercado há muito tempo,são os mais famosos : Oracle, MySQL e SQL Server. Nestes bancos de dados,a interface é constituída por APIs ou drivers do SGBD que executam comandos em SQL (Structured Query Language).

- Os bancos de dados NoSQL vem ganhando espaço no mercado devido a sua baixa exigência de hardware, a sua fácil manutenção e a seu baixo custo de investimento em escalabilidade,são seus representantes mais famosos: Apache e MongoDB. Nestes bancos a interface pode ser simples, utilizando arrays associativos ou pares chave-valor (Key-Values pairs) , porém também pode utilizar o padrão XQuery.

- Seu funcionamento consiste basicamente em: armazenar e gerenciar dados, criando informações, por meio de um SGBD ou outros meios nos bancos NoSQL e também criar tabelas e regras.

- Estado da Arte::

- Os bancos de dados mais recentes e mais utilizados atualmente são: Postgre, MariaDB, Firebird, MySQL, Oracle, SQL Server (Microsoft), CloudSQL, MongoDB e Cassandra (desenvolvido originalmente para o Facebook).Os bancos de dados NoSQL vem ganhando espaço no mercado já que conseguem responder melhor a um grande volume de dados do que os relacionais.

- Integrações:

- Depende das tecnologias: SQL, XQuery, SGBD, API, Hardware.

- Interage com as tecnologias: Servidor, SQL, XQuery.

- Referências:

- http://www.impacta.com.br/blog/2017/01/30/entenda-a-importancia-de-um-banco-de-dados-em-uma-organizacao/

- https://pt.wikipedia.org/wiki/Banco_de_dados

- https://dicasdeprogramacao.com.br/o-que-e-um-banco-de-dados/

- https://pt.wikipedia.org/wiki/Sistema_de_gerenciamento_de_banco_de_dados

- https://www.youtube.com/watch?v=Ofktsne-utM

- https://becode.com.br/principais-sgbds/

- https://pt.wikipedia.org/wiki/NoSQL#Arquitetura

Barramentos

- Conceito:

- Componentes de computadores como; Placa de vídeo, processador, HD são conectados à placa-mãe a partir do que chamamos de barramento (bus),

são as linhas de transmissão que transmitem as informações entre componentes e todos os demais periféricos do computador. Basicamente é o encaixe

de que cada peça precisa para funcionar corretamente, sua principal ação é executar uma comunicação.

- Funcionamento:

- O Barramento é expresso em bits, existe um número de linhas físicas nas quais os dados são enviados simultaneamente.

As três principais funções desempenhadas por tal são:

- Barramento de endereços: (Address Bus) Mostra o local onde os processos devem ser extraídos e para onde devem ser enviados depois de

processados, é usado para selecionar a origem ou destino de sinais transmitidos nos outros barramentos.

- Barramento de dados: (Data Bus) Esse tipo de barramento desempenha a função de troca de dados no computador, dados enviados e recebidos.

O Barramento de Dados é bi-direcional, isto é, pode transmitir em ambas as direções.

- Barramento de controle: (Control Bus) Como o próprio nome já deixa a entender, ele é o que controla as outras funções e sincroniza as

atividades do sistema.

- Estado da Arte:

- Barramento "SATA", substituto da antiga tecnologia "ATA", encontrado no HD, essa nova tecnologia resolveu problemas de perdas de dados

ocasionadas por interferências. Outro exemplo a ser citado é o caso do Barramento PCI-Express, que é basicamente o substituto dos antigos

PCI e AGP, que são peças encontradas em Placa mãe, placa de vídeo de um computador que tem como ação a transferência de dados, a atual

tecnologia é capaz de trabalhar com taxa de transferência de dados com cerca de 4 GB por segundo, fazendo os antigos barramentos sair de linha.

- Integrações:

- Placa de Vídeo; É um componente de um computador que envia sinais deste para o ecrã.

- HD; É uma memória, que serve para armazenar arquivos, programas, jogos e todo tipo de conteúdo que se deseja manter no computador.

- Processador; a sua função é acelerar, endereçar, resolver ou preparar dados, dependendo da aplicação.

- USB; Permite a conexão de periféricos, tem função de transmitir e armazenar dados.

- Placa de rede; Responsável pela comunicação entre os computadores de uma rede

- Referências:

- http://www.cursosdeinformaticabasica.com.br/o-que-sao-barramentos/

- https://www.tecmundo.com.br/hardware/1736-o-que-e-barramento-.htm

- https://br.ccm.net/contents/368-barramento-de-computador

- http://blog.maxieduca.com.br/barramentos-entrada-e-saida/

- http://bloghardwaremicrocamp.com.br/manutencao/tudo-que-voce-precisa-saber-sobre-barramentos/

- http://www.di.ufpb.br/raimundo/ArqDI/Arq5.htm

BI

- Conceito:

- Conhecido tecnicamente como Business intelligence, BI é um processo de coleta, organização, análise, compartilhamento e monitoramento de informações. É um conjunto de técnicas e ferramentas para auxiliar na transformação de dados brutos em informações significativas e úteis. Sendo assim, facilita a análise para criação de projetos dentro de uma empresa.

- Procedimentos:

- Sistemas de BI funcionam da seguinte maneira:

- 1º - Data Warehousing: processo que ocorre a coleta massiva de dados internos e externos ao negócio, o que cria um armazém de dados (DW), que serão ser- utilizados futuramente.

- 2º - Data Mining: nesse processo são buscados padrões nos dados presentes no DW (armazém de dados), assim são criados novos dados e a partir desses são gerados relatórios.

- 3º - Benchmarking: é o processo onde implementa se práticas para o melhoramento do negócio, essas práticas que são criadas a partir de analises dos relatórios que são gerados na fase de DM (Data Mining).

- Sistemas de BI funcionam da seguinte maneira:

- Concorrentes:

- Uma metodologia que está entrando em destaque no mercado é a Data Analytics. Big Data Analytics é o trabalho analítico e inteligente de grandes volumes de dados, estruturados ou não-estruturados, que são coletados, armazenados e interpretados por softwares de altíssimo desempenho. Trata-se do cruzamento de uma infinidade de dados do ambiente interno e externo, gerando uma espécie de “bússola gerencial” para tomadores de decisão, em tempo reduzido.

- Criadores:

- O termo Business Intelligence® surgiu apenas na década de 80, pela empresa Gartner Group, segundo Primak (2008, pag. 5). O mesmo autor, ainda, definiu o Business Intelligence® “como o processo inteligente de coleta, organização, análise, compartilhamento e monitoração de dados contidos em Data Warehouse e/ou Data Mart, gerando informações para o suporte à tomada de decisões no ambiente de negócios”. Desde a década de 90 até a atualidade, foi presenciada uma grande evolução em todos os setores, inclusive no setor da tecnologia da informação e ambiente empresarial. Diante de tamanho progresso, as ferramentas de software ganharam maior abrangência e importância, e o próprio termo Business Intelligence ganhou reconhecimento mundial.

- Referências

BigData

- Conceito:

- Big Data é o termo utilizado para designar o gerenciamento do grande número de dados estruturados e não estruturados, integrando e gerenciando tais juntamente com dados convencionais. Seu grande diferencial é a possibilidade de cruzar esses diferentes tipos de dados para obter insights precisos de maneira eficiente. A partir desta tecnologia podemos saber o que: os usuários da rede estão pensando sobre tal coisa, suas satisfações e insatisfações sobre um determinado produto ou serviço; desejos e necessidade, ou seja, quando você entra em um site de compras como a Amazon, por exemplo, você busca um tipo de produto e isto se torna dados. Esses dados captados na rede serão cruzados com dados internos da empresa para criar insights, informações que dizem sobre o interesse do usuário para as mais diversas finalidades nos mais diversos setores.

- Um dos desdobramentos do Big Data é o Big Data Analytics, que refere-se aos softwares capazes de tratar essa grande quantidade de dados, facilitando a descoberta de certas oportunidades que estão além da compreensão humana.

- O Big Data também pode ser definido pelos seus 5 V's :

- Volume: Imensa quantidade de dados. São dados estruturados e não estruturados, de baixa densidade(por exemplo, fluxo de clicks, feed de dados em uma rede social) que serão convertidos em informações valiosas às empresas.

- Velocidade: O grande fluxo de dados que são recebidos e, se necessário, administrados. Muito importante em segmentos de IoT como de segurança e saúde, que necessitam de avaliações e ações em tempo real. No mercado digital, por exemplo, as aplicações buscam cruzar dados sobre as preferências pessoais do usuário e localização para gerar ofertas de marketing em tempo real para aquele único usuário.

- Variedade: Vários tipos de dados não estruturados. São dados como textos, áudio e vídeo que necessitam de um processamento adicional para que aquilo gere um significado para algo. Após tal processamento esses dados não estruturados passam a ter os mesmos requisitos que os dados funcionais.

- Valor: Todos os dados possuem seu valor, mesmo que esteja "escondido", porém sempre terá tal, que vai desde opinião do cliente até a situação de um hardware que está prestes a falhar. O valor de cada dado é obtido a partir de algoritmos e técnicas quantitativas e investigativas.

- Funcionamento:

- Descreva aqui o funcionamento, as técnicas e detalhes desta tecnologia

- Estado da Arte::

- Cite o estágio mais atual desta tecnologia, ou seja, exemplos de aplicações bem recentes

- Integrações:

- Informe aqui com que outras tecnologias esta depende ou interage

CanvAs

- Conceito:

- Explique aqui o que é a metodologia, para que serve

- Procedimentos:

- Descreva aqui o funcionamento, as técnicas e detalhes da metodologia

- Concorrentes:

- Cite outras metodologias com o mesmo propósito e que concorrem com ela

- Criadores:

- Informe quem criou, propôs ou idealizou esta metologia

Cloud Computing

- Conceito:

- Explique aqui o que é esta tecnologia, para que serve e como pode ser usada

- Funcionamento:

- Descreva aqui o funcionamento, as técnicas e detalhes desta tecnologia

- Estado da Arte::

- Cite o estágio mais atual desta tecnologia, ou seja, exemplos de aplicações bem recentes

- Integrações:

- Informe aqui com que outras tecnologias esta depende ou interage

CLP

Compiladores

- Conceito:

- Um compilador é um software complexo, que cumpre um papel de tradução, conversão e ligação entre um programa escrito em linguagem de programação ou linguagem fonte em um programa de linguagem de máquina ou linguagem objeto. Ou seja, converte um programa escrito em linguagem de programação para uma linguagem cuja o computador entenda. Nos primórdios, os compiladores não traduziam diretamente a linguagem fonte para a linguagem objeto, fazendo-se necessária a tradução em uma linguagem simbólica (Assembly), para que a partir de tal seja feita a tradução em linguagem objeto. Visto isto, fica claro que os compiladores são de suma importância nos tempos atuais, sabendo que cada vez mais há o estreitar da relação homem/máquina, sendo os compiladores hoje, peça fundamental de diálogo e aprimoramento das tecnologias que surgem atualmente.

- Operação:

- As atividades dos compiladores se resumem em duas tarefas, análise e síntese.

- Análise: Onde o compilador analisa o código fonte descrito, reconhecendo a estrutura e significado do programa. Dentro do processo de análise há algumas subdivisões, iniciando o processo pelo analisador léxico que verifica planamente o programa fonte e transforma o texto em um fluxo de tokens, sendo então criada a tabela de símbolos. Logo após a ação do analisador léxico é iniciada a análise sintática, que lê o fluxo de tokens e valida tal estrutura criando em seguida a árvore sintática. Logo esses passos executados entra em ação a análise semântica, que é responsável pela aplicação das regras semânticas.

- Síntese: Onde ocorre a síntese do programa equivalente em Assembly. Aqui ocorre a geração do código intermediário, que cria uma abstração do código, seguida da otimização do código, culminando então na geração do código objeto, que tem a finalidade de geral o código de baixo nível correspondente a arquitetura da máquina alvo.

- As atividades dos compiladores se resumem em duas tarefas, análise e síntese.

- Benchmarking::

- Diferente do compilador o interpretador recebe como entrada uma especificação executável e produz como saída, a execução dessa especificação. Linguagens como PHP, Scheme, Python são interpretadas. Um interpretador pode ser entendido como um processo que, ao invés de visar um conjunto de instruções de um processador, visa produzir o efeito de sua execução. Eles normalmente interpretam uma representação intermediária do programa fonte. Os compiladores e interpretadores possuem muitas características em comum pois podem executar as mesmas tarefas, como por exemplo, analisar um programa e determinar se ele é válido ou não, porém os interpretadores são um tipo de tradutor no qual, algumas fases do compilador são substituídas por um programa que executa o código produzindo o seu efeito.

- Desenvolvedores:

- Existem algumas empresas que desenvolvem compiladores como, IBM, Microsoft, GCC entre outros. CodeBlocks, IDE Visual Studio, Javac, são exemplos de compiladores disponibilizados por eles.

Conectores

CPU

- Conceito:

Acrônimo para Central Processing Unit (Unidade Central de Processamento). É o cérebro do computador, onde é feito o processamento de dados, a maior parte dos cálculos, onde interpreta e executa programas. É composta basicamente por: ULA (Unidade lógica-aritmética), UC (Unidade de Controle) e registradores.

ULA: Executa as operações lógicas e aritméticas determinadas pela UC.

UC: É o elemento que extrai instruções da memória, decodifica e executa, requisitando a ULA quando necessário. Busca dados que devem ser processados, interpreta quais operações devem ser realizadas e envia para outros hardwares com as instruções do código para execução da tarefa.

Registradores: Local onde os dados para o processamento são armazenados temporariamente.

- Funcionamento:

A CPU trabalha em dois ciclos, Ciclo de Busca e Ciclo de Execução.

Logo que o computador é ligado, a CPU entra no Ciclo de Busca, em seguida passa para o Ciclo de Execução e volta para o Ciclo de Busca. Ela continua nesse processo até que precise ser desligada, saindo do Ciclo de Execução para o estado final.

Durante o Ciclo de Busca, é a Unidade de Controle que atua. Uma nova instrução é buscada da Memória para que possa ser decodificada. Nessa fase os registradores PC (Contador de Programas) e IR (Registrador de Instrução) são utilizados.O PC é logo lido para se saber que instrução será executada, essa instrução é trazida para o IR e, finalmente, é decodificada pela Unidade de Controle. Assim que esse processo termina, caso a instrução não diga respeito à um laço, ou à uma repetição, o conteúdo de PC é incrementado. Ou seja, PC recebe PC + 1. Assim, no próximo Ciclo de Busca a instrução do endereço seguinte será carregada da memória e executada. Esse comportamento garante a característica de execução sequencial dos programas.

No passo seguinte a CPU entra em Ciclo de Execução. Agora a Unidade de Controle já sabe exatamente que operação será executada, com quais dados e o que fazer com o resultado. Essa informação é passada para a ULA e os registradores envolvidos. Durante o Ciclo de Execução há cinco possíveis tipos de operação que podem ser executadas. (Citadas no item Integrações)

- Estado da Arte::

Todos os componentes pertencentes a CPU estão integrados em um único chip titulado microprocessador.

Intel e AMD são desenvolvedoras de microprocessadores.

Memória Cache: Atualmente, para melhorar o desempenho, os processadores possuem uma memória de velocidade maior comparada a memória RAM ou disco rígido, para arquivar os dados de maior utilização, evitando acessos constantes à memória.

- Integrações:

As estruturas internas (UC, ULA, Registradores) interagem entre si. Podem se interagir externamente também, como por exemplo:

1.Processador e memória

Trata simplesmente da transferência de dados entre CPU e memória principal;

2.Processador e Entrada e Saída

Diz respeito à transferência de dados entre a CPU e um dispositivo de Entrada e Saída, como teclado, mouse, monitor, rede, impressora etc.;

3.Processamento de Dados

São operações simplesmente de processamento dos dados, como operação aritmética ou lógica sobre os registradores da CPU;

4.Controle

São instruções que servem para controlar os dispositivos do computador, como para ligar um periférico, iniciar uma operação do disco rígido, ou transferir um dado que acabou de chegar pela Internet para a Memória Principal;

5.Operações compostas

São operações que combinam uma ou mais instruções das outras em uma mesma operação.

- Referências:

- https://books.google.com.br/books?hl=pt-BR&lr=lang_pt&id=95KoBQAAQBAJ&oi=fnd&pg=PT3&dq=cpu+computador&ots=06sLj7VMNm&sig=JOfVw1ka_uXqZMGD2X053MDZHBE#v=onepage&q=cpu%20&f=false

- http://www2.ufba.br/~romildo/downloads/ifba/so.pdf

- http://redeetec.mec.gov.br/images/stories/pdf/eixo_infor_comun/tec_inf/081112_org_arq_comp.pdf

- https://www.tecmundo.com.br/intel/209-voce-sabe-o-que-e-uma-cpu-.htm

- http://producao.virtual.ufpb.br/books/edusantana/introducao-a-arquitetura-de-computadores-livro/livro/livro.chunked/ch02s03.html

- http://www.assis.pro.br/public_html/davereed/14-DentroDoComputador.html

- http://www.sourceinnovation.com.br/wiki/Conceito_de_Hardware_%E2%80%93_CPU

Criptografia

- Conceito:

- Explique aqui o que é esta tecnologia, para que serve e como pode ser usada

- Funcionamento:

- Descreva aqui o funcionamento, as técnicas e detalhes desta tecnologia

- Estado da Arte::

- Cite o estágio mais atual desta tecnologia, ou seja, exemplos de aplicações bem recentes

- Integrações:

- Informe aqui com que outras tecnologias esta depende ou interage

Data Mining

- Conceito:

- Atualmente armazenamos uma enorme quantidade de dados diariamente, e a tendência é armazenarmos cada vez mais, pois, boa parte do nós fazemos gera dados. Sabemos que podemos obter informações e conhecimentos a partir de dados e devido a complexidade para operadores humanos realizarem este processo a partir de uma quantidade colossal de dados, foi desenvolvido as técnicas de Data Mining (Mineração de dados,MD), que é o uso de métodos matemáticos, para realizar o processo de obtenção de padrões(conhecimentos) a partir da análise de dados. Podemos obter resultados importantíssimos que são utilizados em diversas áreas, seja para motivos comerciais, de pesquisas, e desenvolvimento de organizações.(KDD: Knowledge Discovery in Databases, tem este mesmo principio de extração de conhecimento apartir de dados, alguns definem MD e o conceito como sinônimos, outros como MD sendo um subtópico de KDD)

- Funcionamento:

- É importante ressaltar que, geralmente a análise de dados através da mineração de dados não é um processo automático, por isso, para que tudo ocorra corretamente é necessário, além das técnicas matemáticas realizadas pelo responsável da aplicação (Equações, Algoritmos, Regressão Logística, Redes Neurais Artificiais, Machine Learning, entre outros), podemos seguir determinados procedimentos fundamentais para a obtenção de um conhecimento importante e útil, planejados pelos especialistas em MD e os especialistas do domínio (organização que vai usar os conhecimentos obtidos, pesquisadores, comerciantes, produtores, entre outros). Existem muitos procedimentos, e nesta abordagem vamos seguir este:

- 1 - Conhecimento do domínio: É o procedimento de definição de objetivos e metas que a análise deve seguir e estudo das exigências e limitações do domínio. No caso de ser bem detalhado e planejado, os próximos procedimentos vão ser mais claros e fáceis de realizar.

- 2 - Pré-processamento:É necessário a aplicação de métodos para a limpeza, organização, união e redução de volume dos dados do domínio para posteriormente serem aplicados às técnicas matemáticas.

- 3 - Extração de padrões:Nessa etapa os especialistas em MD buscam analisar os objetivos e metas que foram planejadas, definir quais técnicas usar e com isso realizam a extração dos padrões por agrupamentos. As metodologias das técnicas usadas são:

- Associações: Busca relações entre itens ocorridas com maiores frequências. Ex, se cliente compra item A ele tem chance de comprar o item B em 60% das vezes, com uma promoção, ele compra o item B em 70% das vezes.

- Classificações: Processo de classificação usando dados para definição de valores a outro dado. Ex se cliente X realiza A e B então classificação de X é determinada.

- Agrupamentos: São estabelecidas relações de um grupo para um item com maior frequência. Ex, uma pessoa A tem um grupo de características x1,x2,x3,x4, portanto, A pode fazer X.

- 4 - Pós-Processamento: Após o processo de extração é obtido diversos padrões, alguns não são tão relevantes, por isso, é necessário realizar questionamentos afim de selecionar os conhecimentos úteis.

- 5 - Utilização do conhecimento: O usuário final do conhecimento decide como vai aplicar o conhecimento obtido.

- É importante ressaltar que, geralmente a análise de dados através da mineração de dados não é um processo automático, por isso, para que tudo ocorra corretamente é necessário, além das técnicas matemáticas realizadas pelo responsável da aplicação (Equações, Algoritmos, Regressão Logística, Redes Neurais Artificiais, Machine Learning, entre outros), podemos seguir determinados procedimentos fundamentais para a obtenção de um conhecimento importante e útil, planejados pelos especialistas em MD e os especialistas do domínio (organização que vai usar os conhecimentos obtidos, pesquisadores, comerciantes, produtores, entre outros). Existem muitos procedimentos, e nesta abordagem vamos seguir este:

- Estado da Arte::

- A mineração de dados pode ser usada em diversas finalidades na atualidade, como por exemplo, na parte de negócios, os conhecimentos podem ser usados para estratégias de possíveis investimentos em determinados produtos, métodos organizacionais da empresa, clientes e funcionários, realizar previsões de mercado, ajudar em realização de contratos com outros negócios ao fazer classificações, estratégias de vendas, estratégias de anúncios e muitos outros.

- Pode ser usado na parte de educação para classificações de métodos de ensino e a qualidade de seus materiais, na parte da saúde para classificar a eficácia de determinados tratamentos ou até descobrir possíveis problemas de saúde que um paciente possui ou poderá possuir caso medidas não sejam tomadas. Já foi usado em ações sociais, em um projeto de reintegração de moradores de rua, usando a metodologia de agrupamento, foi definido qual era a melhor forma de reintegração para cada morador de rua.

- Integrações:

- KDD, sinônimo ou tópico.

- Big Data, Banco de Dados, Data Warehouse e outras formas de armazenamento de dados.

- BI, Data warehousing,KM (Knowledge Management: Gestão do conhecimento) são relacionados.

- Equações, Algoritmos, Regressão Logística, Redes Neurais Artificiais, Machine Learning são métodos/tecnologias matemáticas usadas.

- Referências Bibliográficas

- http://computerworld.com.br/exemplos-de-aplicacoes-de-data-mining-no-mercado-brasileiro

- https://www.youtube.com/watch?v=R-sGvh6tI04

- https://pt.wikipedia.org/wiki/Minera%C3%A7%C3%A3o_de_dados

- https://link.springer.com/article/10.2165/00002018-200730070-00010

- http://www.sourceinnovation.com.br/wiki/Pesquisa_de_Temas_Tecnológicos

- http://www.lbd.dcc.ufmg.br/bdbcomp/servlet/Trabalho?id=8427

- http://www.lbd.dcc.ufmg.br/colecoes/enia/2005/0102.pdf

DMA

- Conceito:

- O Direct Memory Access (DMA), também conhecido como Acesso Direto à Memória, é o nome dado à funcionalidade aplicada em certos hardwares que promove o acesso das portas de entrada e saída à memória de um sistema, sem a necessidade de se utilizar um processador para essa tarefa (FREITAS; MARTINS, 2001, 32). Por mais que pareça algo simples, essa funcionalidade pode ser considerada bastante útil, pois, ao resguardar o processador de mais uma tarefa, ela o livra de uma sobrecarga em operações de recepção e envio de mensagens, e faz com que a comunicação entre o hardware e o sistema seja mais rápida e eficaz (SILVA et al., 2009, p. 2-3).

- Funcionamento:

- De acordo com Maziero (2011, p. 24), o mecanismo de DMA possui um funcionamento simples, e o mesmo autor sugere a seguinte sequência de passos para escrever dados de um buffer em memória RAM para o controlador de um disco rígido:

Passo 1. O processador acessa os registradores do canal DMA associado ao hardware desejado, para informar o endereço inicial e o tamanho da área de memória RAM que contém os dados que serão escritos no disco;

Passo 2. O DMAC (Controlador de Acesso Direto à Memória) reivindica a transferência de dados da memória RAM ao disco, e, em seguida, aguarda essa operação ser concluída. Tal reivindicação é feita ao controlador do disco;

Passo 3. Os dados da memória são enviados para o controlador do disco;

Passo 4. Se a quantidade de dados a serem transferidos for maior do que o tamanho aceitável para que cada transferência ocorra pelo controlador de disco, a pode haver uma repetição da operação anterior;

Passo 5. Após a transferência de dados ser realizada, o próprio DMAC, através de uma interrupção, informa o processador que a operação foi concluída.

- Estado da Arte:

- Os canais de DMA são muito lentos, e, em decorrência disso, são utilizados somente por hardwares mais lentos, tais como placas de som, portas paralelas (padrão ECP) e drivers de disquetes. Os periféricos considerados mais rápidos, por sua vez, utilizam um tipo de versão “aprimorada” do DMA, chamada de Bus Mastering (MORIMOTO, 2002).

- Integrações:

- O DMA possui uma interação direta com a CPU de um periférico, uma vez que ele auxilia na transferência de dados. Além disso, o DMA está presente em alguns modelos de Arduino, que consiste em uma plataforma eletrônica de código aberto baseada em hardware e software fáceis de usar.

- Referências:

- FREITAS, H. C.; MARTINS, C. A. P. S. Processador de Rede com Suporte a Multi-protocolo e Topologias Dinâmicas. In: Workshop em Sistemas Computacionais de Alto Desempenho, 2, 2001, Pirenópolis. Anais... Porto Alegre: Sociedade Brasileira de Computação, 2001. p. 31-38.

- SILVA, V.; GUEDES, S.; BENTES, C.; SILVA, G. Arquitetura e Avaliação do Cluster de Alto Desempenho Netuno. In: Simpósio em Sistemas Computacionais de Alto Desempenho, 10, 2009, São Paulo. Anais... São Paulo: WSCAD, 2009. p. 1-8.

- MAZIERO, C. A. Sistemas Operacionais: gerência de entrada e saída. 2011. Disponível em: <http://files.francielamorim.webnode.com.br/200000056-7bb657cb1a/SisOper%2007%20-%20Gerencia%20Ent_Saida.pdf>. Acesso em: 13 abr. 2018.

- MORIMOTO, C. E. Manual de Hardware Completo. 3 ed, 2002. Disponível em: <http://www.guiadohardware.net>. Acesso em: 13 abr. 2018.

- http://www.sourceinnovation.com.br/wiki/Conceito_de_Hardware_%E2%80%93_DMA

- http://www.sourceinnovation.com.br/wiki/Tecnologia_Ardu%C3%ADno

- https://www.arduino.cc/en/Guide/Introduction#

ERP

eXtreme Programming

- Conceito

- A eXteme Programming (Programação Extrema, em Português), também conhecida como XP, é uma metodologia ágil aplicada como processo de desenvolvimento de softwares. É, majoritariamente, atribuída a equipes de pequeno e médio porte, que baseiam seu trabalho em requisitos vagos e que se modificam rapidamente. Como características conceituais, a XP traz consigo um foco desenvolvimentista em sistemas orientados a objeto e em enquadramento de projeto incremental (ou iterativo), no qual o sistema começa a ser implementado logo no início e vai ganhando novas funcionalidades ao longo do tempo.

- Classificação Metodológica e "Manifesto Ágil"

- Em relação à classificação metodológica, como já mencionado, a eXtreme Programming se encaixa no grupo das metodologias ágeis. É importante ressaltar e esclarecer esse ponto, pois a definição e o funcionamento da XP são altamente ligados ao contexto histórico e ao surgimento das inovadoras metodologias ágeis. O marco principal desse contexto é nomeado como "Manifesto Ágil", pois, embora as práticas da XP já existissem desde 1996, foi somente cinco anos depois que seus líderes, através do manifesto, definiram seu conceito atualizado, formalizado e completo, composto pelas premissas originais de Kent Beck (criador da metodologia), incrementadas pelos valores do documento, eventualmente, redigido.

- No ano de 2001, no resort Snowbird, nas montanhas nevadas do estado de Utah, EUA, foi realizada uma reunião que contou com a presença de 17 líderes da comunidade de métodos de desenvolvimento de software, como eXtreme Programming, Scrum e outros - na época denominados por métodos leves. Nessa reunião, foram observados pontos em comum, entre as ideias de Beck, Shwaber e Sutherland (criadores do Scrum), e outros desenvolvedores da área, fato que levou à decisão de documentar e registrar tais pontos, dados em quatro valores (filosofia) e doze princípios (prática), intitulados por "Manifesto Ágil". Esse movimento abriga e considera metodologias que propõem os seguintes valores:

- Indivíduos e interação entre eles mais que processos e ferramentas;

- Software em funcionamento mais que documentação abrangente;

- Colaboração com o cliente mais que negociação de contratos;

- Responder a mudanças mais que seguir um plano.

- Procedimentos, Princípios e Práticas

- A metodologia é composta por uma série de princípios e práticas, que possuem a finalidade de conferir maiores eficiência e rendimento nos aspectos de rapidez, qualidade do produto e, bom e constante relacionamento com o cliente. A origem dos conceitos das práticas da XP é o conjunto de princípios constados no "Manifesto Ágil", em um número de doze. Essa lista pode ser encontrada no seguinte endereço: http://www.manifestoagil.com.br/principios.html

- Além das bases conceituais, existem também algumas práticas específicas da eXtreme Programming que se notabilizam pela dinâmica e o encaixe às características para desenvolver em períodos e movimentos que economizam tempo. São elas:

- Cliente Presente: O XP trabalha com a premissa de que o cliente deve conduzir o desenvolvimento a partir do feedback que recebe do sistema.

- Jogo do Planejamento: No início de cada iteração ocorre o jogo do planejamento. Trata-se de uma reunião onde o cliente avalia as funcionalidades que serão

implementadas.

- Stand Up Meeting: A equipe se reúne a cada manhã para avaliar o trabalho que foi executado no dia anterior e priorizar aquilo que será implementado no dia que se

inicia.

- Programação em Par: Os desenvolvedores implementam as funcionalidades em pares, ou seja, diante de cada computador, existem sempre dois desenvolvedores que trabalham juntos para produzir o mesmo código.

- Desenvolvimento Guiado para Testes: Testes são escritos para cada funcionalidade antes de codificá-las. Fazendo isso, eles aprofundam o entendimento das

necessidades do cliente.

- Refactoring: O refactoring é o ato de alterar um código sem afetar a funcionalidade que ele implementa. O objetivo é tornar o software mais simples de ser mantido.

- Código Coletivo: Os desenvolvedores têm acesso a todas as partes do código e podem alterar aquilo que julgarem importante sem pedir autorização de outra pessoa.

- Código Padronizado: Para facilitar a manutenção no código por parte de toda a equipe, padrões de codificação são definidos tornando o sistema mais homogêneo e permitir que qualquer membro da equipe tenha condições de dar manutenção no sistema.

- Design Simples: Para que o cliente possa obter feedback logo, a equipe precisa ser ágil no desenvolvimento, o que a leva a optar pela simplicidade do design.

- Metáfora: Para facilitar a criação de um design simples, a equipe de desenvolvimento utiliza metáforas, já que elas têm o poder de transmitir ideias complexas de

forma simples.

- Ritmo Sustentável: Para garantir que a equipe tenha sempre o máximo de rendimento e produza software com melhor qualidade possível, o XP recomenda que os

desenvolvedores trabalhem apenas oito horas por dia e evitem fazer horas-extras, visto que é essencial estar descansado a cada manhã, de modo a utilizar a mente na sua plenitude.

- Integração Contínua: Prática utilizada com o objetivo de checar/testar toda a aplicação, sempre que uma nova funcionalidade é implementada, seja de forma manual,

ou automática, forma esta, que se utiliza de ferramentas especializadas para tal.

- Releases Curtos: O XP tem como objetivo gerar um fluxo contínuo de valor para o cliente. Sendo assim, ele trabalha com releases curtos, ou seja, a equipe produz

um conjunto reduzido de funcionalidades e coloca em produção rapidamente.

- 40 Horas Semanais*: a XP assume que não se deve fazer horas extras constantemente. Caso seja necessário trabalhar mais de 40 horas pela segunda semana

consecutiva, existe um problema sério no projeto que deve ser resolvido não com aumento de horas trabalhadas, mas com melhor planejamento, por exemplo.

Fonte: TELES (2006)/Comparação entre Metodologias Ágeis e Tradicionais para o Desenvolvimento de Software *[1]-pdf disponível para download

- Outras Metodologias Concorrentes

- As metodologias ágeis cresceram muito ao longo dos anos, desenvolvendo instituições diversas e organizações que definem originalmente tais conceitos. Abaixo estão, portanto, algumas das principais metodologias concorrentes da eXtreme Programming. Os endereços, que seguem, são para maiores informações específicas sobre as concorrentes, dadas em sítios oficiais das empresas que gestacionam suas aplicações:

- Scrum - https://www.scrumguides.org/scrum-guide.html

- MSF - Microsoft Solutions Framework - https://msdn.microsoft.com/pt-br/library/jj161047(v=vs.120).aspx

- DSDM - Dynamic System Development Model - https://www.agilebusiness.org/

- LSD - Lean Software Development - https://www.lean.org.br/o-que-e-lean.aspx

- As metodologias ágeis cresceram muito ao longo dos anos, desenvolvendo instituições diversas e organizações que definem originalmente tais conceitos. Abaixo estão, portanto, algumas das principais metodologias concorrentes da eXtreme Programming. Os endereços, que seguem, são para maiores informações específicas sobre as concorrentes, dadas em sítios oficiais das empresas que gestacionam suas aplicações:

- Criadores

- Em 1996, o programador e consultor em T.I, Kent Beck, idealizou e introduziu as primeiras primeiras práticas da eXtreme Programming, que eram frutos de anos de experiência e trabalho em métodos leves, ao lado de seu parceiro Ward Cunningham. Na ocasião, a empresa Chrysler solicitou os serviços de Beck, para unificar quatro sistemas de softwares legado, com 20 anos de uso. O trabalho era um tanto complicado, pois a função do sistema era controlar a folha de pagamento de quase 86 mil funcionários da empresa. Para atingir o objetivo, Kent não apenas avaliou e orientou diversas pessoas da grande equipe disponível, como distribuiu funções e dividiu, em pequenos grupos, o contingente de responsáveis pela tarefa, introduzindo, pela primeira vez, sua metodologia. No fim, com 14 meses de trabalho, o resultado foi um grande sucesso e a XP começou a ser adotada por diversos times de desenvolvimento pelo mundo.

- Referências

- https://www.ft.unicamp.br/liag/Gerenciamento/monografias/monogafia_metodos_ageis.pdf

- https://www.culturaagil.com.br/manifesto-agil-como-tudo-comecou/

- http://www.forscience.ifmg.edu.br/forscience/index.php/forscience/article/view/117/134

- https://channel9.msdn.com/posts/Entrevista-com-Ken-Schwaber--criado-do-Scrum--na-Microsoft-Brasil

- http://brodtec.com/kenji-jeff

- https://hiperbytes.com.br/xp/metodologia-xp-extreme-programming-breve-historico-da-xp/

- https://www.devmedia.com.br/introducao-ao-extreme-programming-xp/29249

- http://www.martinsfontespaulista.com.br/anexos/produtos/capitulos/143120.pdf

- http://infocomp.dcc.ufla.br/index.php/INFOCOMP/article/view/68 (download arquivo do em pdf)

- https://www.lean.org.br/o-que-e-lean.aspx

- https://www.agilebusiness.org/

- https://msdn.microsoft.com/pt-br/library/jj161047(v=vs.120).aspx

- https://www.scrumguides.org/scrum-guide.html

Firewall

- Conceito:

Com o passar dos anos e o desenvolvimento da tecnologia as pessoas começaram a armazenar dados em inúmeros dispositivos e a segurança deles se tornou algo imprescindível. Firewall foi criado com o intuito de ser uma ferramenta de proteção para computadores e redes, sendo baseado em hardware ou software, sendo a segunda opção o mais comum. Seguindo as regras e instruções ele impede que Malwares como, por exemplo, os vírus afetem o computador e ele continue funcionando normalmente.

- Operação:

O Firewall determina quais operações de transmissão ou recepção de dados podem ser executadas, para isso ele é constituído de regras e instruções, como podemos ver no exemplo a seguir: ""(regra 1, ação 1)"" ""(regra 2, ação 2)"" ""(regra 3, ação 3)"" "" etc.""

Ao receber uma quantidade de dados, o firewall executa as regras na ordem ate encontrar uma que corresponde aos dados. Caso ele encontre ele poderá executar ações como aceitar pacote, encaminhar pacote e caso não encontre ele executará ações como recusar pacote, ignorar pacote. O firewall poderá ser configurado de diversas maneiras, alguns exemplos a seguir: -Bloquear totalmente o tráfico no computador ou rede, assim isola completamente o computador ou rede. -Criar uma regra para que o aplicativo aguarde autorização do Usuário ou administrador - Autorizar o tráfego de determinados tipos de dados e bloquear outros. Tipos de Firewall: -Filtragem de Pacotes (packet filtering): -Firewall de Aplicação (proxy services): -Inspeção de Dados (Stateful Inspection) Arquitetura dos Firewall; O modo como o Firewall é implementado, por possuir vários tipos ele consegue ser usado de diversas formas, alguns exemplos a seguir: -Arquitetura Dual-Homed Host -Screened Host -Screened Subnet

- Benchmarking::

Cite alguns sistemas que fazem o mesmo ou próximo do que este faz

- Desenvolvedores:

Informe que empresa, profissional ou instituição comercializa ou disponibiliza este software

Frameworks

- Conceito:

- Framework, palavra em inglês para estrutura, é um conjunto de classes inter-relacionadas, códigos-fonte, funções, técnicas e metodologias que facilitam o desenvolvimento de softwares. Em outras palavras, framework é como se fosse uma "fonte" de onde se pode desenvolver algo mais específico e complexo. A utilização dos frameworks em softwares, está diretamente relacionada à economia de tempo que o mesmo providencia, já que o usuário não precisaria começar tudo do zero. Além disso, os frameworks podem ser úteis para que o programador foque diretamente no processo de desenvolvimento de seu projeto, já que não gastaria muito tempo e pensamento programando o que é sempre comum nesses mesmos projetos.

- Operação:

- A utilização de um framework depende de um conhecimento de pelo menos nível básico da linguagem que aquele framework aborda, por exemplo, javascript, PHP, entre outras linguagens. Após feita a análise de requisitos de um projeto de software e instalado um framework, o programador poderá fazer seu código normalmente e, quando necessário, chama uma classe presente no framework que já teve seu código desenvolvido. Os frameworks costumam disponibilizar um documento em seus sites que contém informações para como utilizar-lo, já que, diferentemente das bibliotecas, os frameworks possuem módulos estruturados que seguem algum padrão (como por exemplo o MVC - Model View Controller, que faz a separação entre um modelo de dados, a interface do usuário e o controlador de tudo operando junto), e que se esses padrões não forem seguidos, torna-se quase impossível construir uma aplicação.

- Benchmarking:

- Frameworks para C++:

- CollEntRes -> Versão mais recente: 1.1.0, lançada em 20/02/2018;

- Poco -> Versão mais recente: 1.9.0, lançada em 08/03/2018;

- CppCMS -> Versão mais recente: 1.2.0, lançada em 16/01/2018;

- Frameworks para Java:

- Spring -> Versão mais recente: 5.0.4, lançada em 19/02/2018;

- Google Web Toolkit -> Versão mais recente: 2.8.1, lançada em 24/04/2017;

- Apache Wicket -> Versão mais recente: 7.9.0, lançada em 19/09/2017;

- Frameworks para PHP:

- CodeIgniter -> Versão mais recente: 3.1.8, lançada em 23/03/2018;

- CakePHP -> Versão mais recente: 3.5.14, lançada em 19/03/2018;

- Yii -> Versão mais recente: 2.0.14, lançada em 19/02/2018;

- Desenvolvedores:

- Algumas empresas grandes trabalham bastante com frameworks e por estarem ligadas ao mundo de desenvolvimento de softwares, disponibilizam muitos frameworks para os outros usuários. Algumas dessas empresas são: Google, Apache, MIT, GPL. A importância de disponibilizar esses frameworks para todo mundo é que facilita a compartilhação de informação entre os usuários, visto que torna-se possível o "upgrade" desses frameworks.

IA

- Conceito:

- A palavra inteligência, vem do latim inter (entre) e legere (escolher), e a artificial vem do artificiale em latim, ou seja, juntando os significados dessas palavras pode-se chegar à conclusão que a Inteligência Artificial é uma tecnologia criada pelo homem para fazer com que as máquinas possam ter a capacidade de pensar como seres humanos, por exemplo a de tomar decisões, comunicar-se, aprender e armazenar. Além disso, pode ser definida também como um ramo da Ciência da Computação que visa em desenvolver dispositivos e mecanismos que simulem a capacidade humana, enfim, esse termo IA, criado pelo professor universitário John McCarthy, descreve o mundo onde as máquinas poderiam resolver problemas que atualmente são designados aos humanos.

- A Inteligência artificial é e/ou pode ser usada para diversas formas de auxiliar as pessoas, como: a ferramenta de pesquisa do Google que preenche as buscas utilizando esse recurso; a robô Sophia criada para ajudar nos cuidados da saúde, terapia, educação e atendimento de clientes que consegue conversar, andar e fazer expressões faciais mesmo, por enquanto, com suas limitações; o Facebook utilizando o reconhecimento de imagem para reconhecer as pessoas que estão na foto para marca-las; carros automáticos desenvolvidos para tentar evitar colisões e engarrafamento; a assistente pessoal Siri, que utiliza processamento de voz para conversar com seus usuários; entre outros exemplos.

- Funcionamento:

- Para a Inteligência Artificial funcionar necessita de uma combinação de diversas tecnologias, e várias áreas da ciência da computação compõe o que é IA, como:

- Machine Learning (aprendizado de máquina): é o conceito de uma máquina de aprende com um mínimo de informação possível, no qual através dos dados recebidos possa decidir em qual alternativa é melhor ser tomada, dependendo menos de ajustes, como, por exemplo, as recomendações personalizadas na Netflix e na Amazon. Sendo o fundamental impulsionador da IA.

- Deep Learning (aprendizado profundo): trabalha com algoritmos mais complexos imitando as redes neurais do cérebro humano, permitindo que as máquinas possam aprender com pouca ou nenhuma supervisão.

- Processamento de Linguagem Natural (PLN): ao utilizar os conceitos de Machine Learning faz com que a máquina detecte padrões em grandes conjuntos de dados puros e reconheça a linguagem natural, sendo capaz de compreender sentimentos, como em análise de publicação nas redes sociais.

- Uma das primeiras áreas a utilizar IA foram as indústrias, utilizando desde as matérias-primas até os produtos propriamente dito, realizando funções básicas que não precisam de ajuda manual.

- Primeiramente um desenvolvedor para desenvolver algo que envolva IA deve-se criar leis no qual a máquina criada deverá seguir para saber quais decisões seguir ou não tomar sobre certas situações ou atitudes, conhecidas como Leis de Asimov ou Leis de Platina. Dentre essas leis se encontra a proibição de auto replicação, proibição de expedição, proibição de acesso remoto, confidencialidade e entre outras.

- Para a Inteligência Artificial funcionar necessita de uma combinação de diversas tecnologias, e várias áreas da ciência da computação compõe o que é IA, como:

- Estado da Arte::

- Atualmente a Inteligência Artificial se encontra em desenvolvimento constante e acelerado, trazendo diversos avanços ou possíveis consequências, como se dizia Stephen Hawking em uma entrevista à BCC, "o desenvolvimento da inteligência artificial total poderia significar o fim da raça humana".

- Dentre os exemplos atuais podemos citar:

- Robô Sophia: criada pela empresa Hanson Robotics e ligada em 2015, faz 62 expressões faciais e de pescoço, consegue interagir com pessoas e andar e contém câmeras nos olhos para “ler” as reações faciais e tentar corresponder da melhor forma possível. Para isso ela possui três interações: uma plataforma de pesquisa em IA, para responder perguntas simples; um programa que recita frases pré-carregadas; e um “chatbot”, que olha e ouve para as pessoas e escolhe uma resposta apropriada para a situação e dar dados retirados da internet. Além disso, conseguiu uma cidadania na Arábia Saudita.

- Placa de vídeo Titan V: criada pela empresa de hardware NVIDIA, para área científica voltada a aplicações da Inteligência Artificial para tentar ultrapassar os limites tanto da IA quanto da computação de alto performasse, de acordo com o presidente e fundador Jensen Huang.

- Integrações:

- A Inteligência Artificial só é possível com a interação de big data (acesso a processo de dados não identificados, para continuar seu aprimoramento), computação em nuvem (grande potência com custo acessível, para um processamento rápido e eficiente) e bons modelos de dados (processando, classificando e analisando de forma inteligente).

- Referências:

- https://www.salesforce.com/br/products/einstein/ai-deep-dive/

- http://www.sourceinnovation.com.br/wiki/Intelig%C3%AAncia_Artificial

- http://www.dca.fee.unicamp.br/~martino/disciplinas/ia369/trabalhos/t4g1

- https://www.youtube.com/watch?v=eqvmNhqdD38

- https://www.tiespecialistas.com.br/2010/09/como-funciona-uma-inteligencia-artificial/

- https://tecnologia.uol.com.br/noticias/redacao/2018/01/10/robo-sophia-ja-sabe-andar.htm

- http://www.bbc.com/portuguese/noticias/2014/12/141202_hawking_inteligencia_pai

- http://www.teratime.com.br/blog/2017/12/08/nova-nvidia-titan-v-placa-de-video-para-inteligencia-artificial/

IDE

- Conceito:

- IDE, do inglês, Integrated Development Environment, é definido como um ambiente de desenvolvimento integrado que reúne editor, compilador e depurador em um único software, com o objetivo de tornar o processo de codificação mais eficiente e produtivo.

- Operação:

- Descreva aqui como funciona a operação deste sistema

- Benchmarking:

- Cite alguns sistemas que fazem o mesmo ou próximo do que este faz

- Desenvolvedores:

- Informe que empresa, profissional ou instituição comercializa ou disponibiliza este software

Integração Contínua

- Conceito:

- Integração contínua consiste em uma prática de desenvolvimento que permite a disponibilização de uma interface a qual possui um código-fonte central, possibilitando adicionar novas partes ou alterações de algum código já integrado. Essa técnica visa a rapidez para disponibilização/atualização do software e simplifica a comunicação entre a equipe de desenvolvimento que não precisa estar no mesmo lugar para colaborar o projeto, além de facilitar a detecção e correção de bugs do conjunto.

- Funcionamento:

- O código-fonte(central) é disponibilizado em um ambiente onde permite a integração de novas partes de código para complementar a central e, durante o processo de adição, a central é capaz de testar se o código-fonte em conjunto ao código adicionado são compatíveis. Dependendo do ambiente, é possível parametrizar requisitos para a validação da nova adição.

- Estado da Arte:

- Existem serviços(centrais) pagos, exemplo: Amazon CodeBuild e GitHub; e serviços gratuitos opensource: TortoiseCVS e Apache Subversion. Os serviços gratuitos possuem a característica de serem OpenSource, permitindo que a ferramenta de repositório(central) seja evoluída assim como o projeto que utiliza a ferramente.

- Integrações:

- A integração contínua precisa de um repositório central que será hospedado em um ambiente que permite acesso de qualquer lugar de forma segura, logo será necessário internet e proteção para a conexão e compartilhamento de arquivos. O repositório central deve estar dotado de um controle de alterações, sistema de rollback(ponto de restauração) e automatização de testes.

- Referências:

Inteligência Cognitiva

Conceito: Primeiramente vamos definir o que é cognição,que seria o processo de adquirir o conhecimento incluindo estados mentais como raciocínio, atenção, juízo entre outros.Sendo assim a Inteligência Cognitiva pode ser resumida em novos pensamentos, que são adquiridos através da sua atividade ela traz o novo e pode transformar as situações em novas perspectivas diferentes das experiências anteriores.Por isso é muito importante sair da zona de conforto e buscar novos conhecimentos novas experiências,que estimulem todas as habilidades envolvidas e uma dica para isso seria com o aprendizado de programação e robótica, desta forma seria possível assimilar todas elas.

Funcionamento: A inteligência cognitiva é estruturada em duas categorias: atividade criativa e atividade reprodutiva, a criativa, a pessoa cria novas condições e situações que ainda não teve experiência, é elaborado pela criatividade de cada um. Já a atividade reprodutiva é o processo de identificação e reprodução das condições e situações já estabelecidas através do ambiente, das relações com outras pessoas, meios de informações, experiências já vivenciadas, entre outros.

Estado da Arte:

Hoje esta tecnologia vem sendo usada na área da saúde ajudando na agilidade e na mobilidade e na segurança do paciente, e também ajudando na transição entre computador e se humano, esta tecnologia vem avançando cada dia mais e auxiliando diversas empresas da área tecnológica.A tecnologia já está sendo aplicada em diversos países para solucionar diferentes desafios, principalmente nas áreas de engajamento com clientes, suporte à decisão clínica e apoio à descoberta científica.

Integrações: Internet das coisas, Inteligencia artificial, Linguagens de programação entre outros.

Referências.' http://saudebusiness.com/noticias/computacao-cognitiva-na-saude-revolucao-da-inteligencia-artificial/

http://www.ctrlplay.com.br/blog/o-que-e-inteligencia-cognitiva-e-como-a-criatividade-pode-ajudar/

IoT

- Conceito:

- "Internet das Coisas é um conceito em que o real e o virtual se conectam para criar um mundo mais inteligente em diferentes segmentos da sociedade." Renata Rampim.

- A Internet of Things (IoT) ou Internet das Coisas é simplesmente conectar coisas na Internet, por ex. dispositivos, carros, prédios, uma casa, etc, utilizando hardwares com sensores e softwares, conectados numa rede na Internet, coletando e processando esses dados.

- A IoT permite que objetos coletem dados e enviem para uma central e que sejam controlados remotamente pela Internet. Criando, assim, oportunidades entre o mundo físico e o digital.

- Portanto, isso resulta em melhoria de eficiência e precisão de objetos, com impacto na economia, como economizar tempo e dinheiro usando IoT.

- Funcionamento:

- Precisa-se apenas de um hardware e um software, alguns casos são simples, outros mais complexos. O hardware que é a parte física, por ex. um Arduino, um Raspberry Pi, ou hardware proprietário. Já a parte de software que é a programação, em geral é usado C, C++ e Python.

- É conectado alguns sensores no hardware, programa a leitura desses sensores para acionar algum botão e/ou motor, em seguida, esses dados são enviados a um servidor central e processados.

- Estado da Arte:

- Atualmente, estão surgindo muitos outros produtos de IoT em uma escala comercial, acessível a quase todos, por ex. o Nest, que foi comprado pelo Google, é um termostato inteligente que controla temperatura de ambientes, muito popular na América do Norte. O principal diferencial do Nest é um sensor de temperatura conectado a uma inteligência artificial, que lê a temperatura do ambiente e conforme regulado no uso do dia a dia, começa a configurar-se automaticamente.

- Outro exemplo, é o Philips Hue que são lâmpadas Leds coloridas, colocadas num soquete normal de lâmpada e interligado a um Hub conectado à Internet, e a um App no smartphone consegue configurar a luz de toda a casa.

- E também, tem os SmartThings, que transforma a casa em Smart Home, permite controlar remotamente objetos de toda casa, conectados e centralizados por um aplicativo de celular. Através de um Hub conectado à Internet e a todos os dispositivos nele, por ex. Philips Hue, fechadura digital, lâmpada, controlador de temperatura, sensor de presença, sensor de movimento, etc.

- Atualmente, estão surgindo muitos outros produtos de IoT em uma escala comercial, acessível a quase todos, por ex. o Nest, que foi comprado pelo Google, é um termostato inteligente que controla temperatura de ambientes, muito popular na América do Norte. O principal diferencial do Nest é um sensor de temperatura conectado a uma inteligência artificial, que lê a temperatura do ambiente e conforme regulado no uso do dia a dia, começa a configurar-se automaticamente.

- Integrações:

- Inteligência Artificial, Machine Learning, Linguagens de Programação, Redes, Arduino, etc.

- “Se você acha que a internet mudou a sua vida, pense novamente. A Internet das coisas está prestes a mudar tudo de novo!” — Brendan O’Brien, cofundador, Aria Systems

- Referências

- https://nest.com/thermostats/nest-learning-thermostat/overview/

- https://www2.meethue.com/pt-br

- https://www.smartthings.com/

- https://create.arduino.cc/projecthub/projects/tags/iot

- https://docs.aws.amazon.com/pt_br/iot/latest/developerguide/iot-sdk-setup.html

- https://www.amazon.com.br/Internet-das-Coisas-Sem-Mist%C3%A9rios-ebook/dp/B01LWKBDGS

- https://www.youtube.com/watch?v=-EA9UBEahDY

IPSec

- Conceito:

- Explique aqui o que é esta tecnologia, para que serve e como pode ser usada

- Funcionamento:

- Descreva aqui o funcionamento, as técnicas e detalhes desta tecnologia

- Estado da Arte::

- Cite o estágio mais atual desta tecnologia, ou seja, exemplos de aplicações bem recentes

- Integrações:

- Informe aqui com que outras tecnologias esta depende ou interage

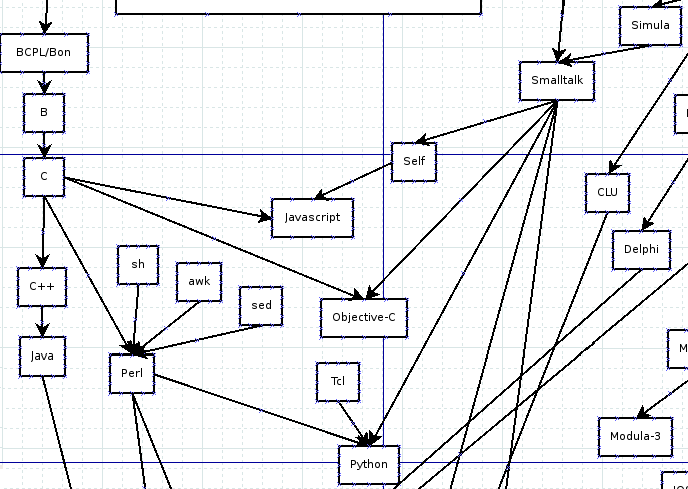

Linguagens de Programação

- Conceito:

- É um método padronizado para comunicar instruções para um computador. É um conjunto de regras sintáticas e semânticas usadas para definir um programa de computador. Permite que um programador especifique precisamente sobre quais dados um computador vai atuar, como estes dados serão armazenados ou transmitidos e quais ações devem ser tomadas sob várias circunstâncias. Linguagens de programação podem ser usadas para expressar algoritmos com precisão.

- O conjunto de palavras, compostos de acordo com essas regras, constituem o código fonte de um software. Esse código fonte é depois traduzido para código de máquina, que é executado pelo microprocessador.

- Uma das principais metas das linguagens de programação é que programadores tenham uma maior produtividade, permitindo expressar suas intenções mais facilmente do que quando comparado com a linguagem que um computador entende nativamente (código de máquina). Assim, linguagens de programação são projetadas para adotar uma sintaxe de nível mais alto, que pode ser mais facilmente entendida por programadores humanos. Linguagens de programação são ferramentas importantes para que programadores e engenheiros de software possam escrever programas mais organizados e com maior rapidez.

- Funcionamento:

- Ao usarmos uma linguagem de programação você cria o chamado “Código Fonte”. Um código fonte é um conjunto de palavras escritas de acordo com as regras sintáticas e semânticas de uma linguagem. Regras sintáticas dizem respeito à forma de escrita e regras semânticas ao conteúdo. O importante para sabermos agora é que o código fonte não é executado pelo computador. O computador não entende o código fonte, mas sim o código que representa seu programa e dados em memória (nos nossos exemplos o código é binário). Assim, é preciso traduzir o código fonte para o formato que o computador entenda. Este formato compreensível pelo computador é chamado de “Código de Máquina”. A este processo de “tradução” é dado o nome de Compilação.

- Estado da Arte:

- Existem várias linguagens de programação; de acordo com o Índice Tiobe, as 20 mais populares são:

- 1.Java

- 2.C

- 3.C++

- 4.Python

- 5.C#

- 6.JavaScript

- 7.Visual Basic .NET

- 8.R

- 9.PHP

- 10.MATLAB

- 11.Swift

- 12.Objective-C

- 13.Assembly

- 14.Perl

- 15.Ruby

- 16.Delphi / Object Pascal

- 17.Go

- 18.Scratch

- 19.PL/SQL

- 20.Visual Basic

- As linguagens de programação podem ser classificadas e sub-classificadas de várias formas. Classificação da ACM - Association for Computing Machinery

- A ACM mantém um sistema de classificação com os seguintes sub-itens:

- Linguagens aplicativas, ou de aplicação

- Linguagens concorrentes, distribuídas e paralelas

- Linguagens de fluxo de dados

- Linguagens de projeto

- Linguagens extensíveis

- Linguagens de montagem e de macro

- Linguagens de microprogramação

- Linguagens não determinísticas

- Linguagens não procedurais

- Linguagens orientadas a objeto

- Linguagens de aplicação especializada

- Linguagens de altíssimo nível

- Kotlin( 2016/2017 )

- É uma Linguagem de programação que compila para a Máquina Virtual Java e que também pode ser traduzida para JavaScript e compilada para código nativo. É desenvolvida pela JetBrains, seu nome é baseado na ilha de Kotlin onde se situa a cidade russa de Kronstadt, próximo à São Petersburgo. Apesar de a sintaxe de Kotlin diferir da de Java, Kotlin é projetada para ter uma interoperabilidade total com codigo Java, permitindo que as empresas possam fazer uma migração gradual de Java para Kotlin.

- Compatibilidade: Kotlin é totalmente compatível com o JDK 6, garantindo que os aplicativos possam ser executados em dispositivos Android mais antigos, sem problemas. A ferramenta Kotlin é totalmente suportada no Android Studio e compatível com o sistema de compilação do Android.

- Desempenho: um aplicativo Kotlin é tão rápido quanto um Java equivalente, graças a uma estrutura de bytecodes muito semelhante. Com o suporte da Kotlin para funções inline, o código usando lambdas geralmente é executado ainda mais rápido que o mesmo código escrito em Java.

- Interoperabilidade: o Kotlin é interoperável a 100% com Java, permitindo usar todas as bibliotecas Android existentes em um aplicativo Kotlin.

- Tempo de compilação: o Kotlin suporta compilação incremental eficiente, por isso, enquanto há algumas sobrecargas adicionais para construções limpas, as compilações incrementais geralmente são tão rápidas ou mais rápidas do que com o Java.

- Curva de aprendizado: para um desenvolvedor Java começar com o Kotlin é muito fácil. O conversor automático Java para Kotlin incluído no plugin Kotlin ajuda com os primeiros passos.

- Integrações:

- Uma linguagem de programação pode ser convertida, ou traduzida, em código de máquina por compilação ou interpretada por um processo denominado interpretação. Em ambas ocorre a tradução do código fonte para código de máquina.

- Um compilador é um programa de computador (ou um grupo de programas) que, a partir de um código fonte escrito em uma linguagem compilada, cria um programa semanticamente equivalente, porém escrito em outra linguagem, código objeto. Classicamente, um compilador traduz um programa de uma linguagem textual facilmente entendida por um ser humano para uma linguagem de máquina, específica para um processador e sistema operacional.