Debate

| Tópico | Tema 1 | Tema 2 | Tema 3 | Tema 4 | Tema 5 | Tema 6 | Tema 7 | Data |

|---|---|---|---|---|---|---|---|---|

| Hardware | Barramentos | Periféricos | Processadores | Portas | Memória RAM | Disco Rígido | Memória ROM | 09/05 |

| Software | App | ERP | Sistema Embarcado | Frameworks | Firmware | SO | Web | |

| Development | Algoritmos | API | Compiladores | IDE | Linguagens de Programação | Open Source | Webservice | |

| DataBase | Banco de Dados | Normalização | SQL | BigData | ETL | Data Mining | NoSQL | |

| Methods | Canvas | eXtreme Programming | Integração Contínua | Modelo Orientado a Serviço | Scrum | UML | FDD | |

| Net | Firewall | Internet | IP | Protocolos | Redes de Computadores | Roteador | DNS | |

| Cloud | Virtualização | Modem | DNS | Criptografia | Cloud Computing | Plataformas | SaaS | |

| Internet of Things | RFId | Raspberry | IPSec | IoT | CLP | Arduino | Sensores | |

| State of the Art | BlockChain | IA | Inteligência Cognitiva | Machine Learning | RA | Bots | Redes Neurais |

Tabela de Temas

| Nro | Tema | Tópico | Aluno |

|---|---|---|---|

| 01 | Algoritmos | Development | Giovana Campioto |

| 02 | API | Development | Gabriel Rodrigues |

| 03 | App | Software | Elton |

| 04 | Arduino | Internet of Things | Fábio |

| 05 | Banco de Dados | Database | Guilherme Rodovalho |

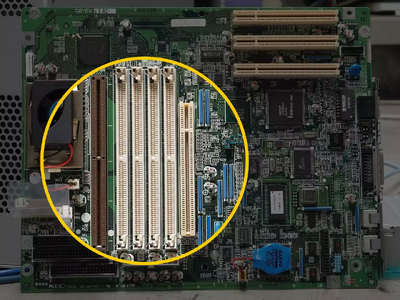

| 06 | Barramentos | Hardware | Pablo Pierre da Nóbrega |

| 07 | BigData | Database | Pedro Henrique Chagas |

| 08 | BlockChain | State of the Art | Arthur Maia |

| 09 | Bots | State of the Art | Mateus Gonçalves Canavieira |

| 10 | Canvas | Methods | Prof. Luiz Cláudio |

| 11 | Cloud Computing | Cloud Computing | Mateus Ferreira Silva |

| 12 | CLP | Internet of Things | Nathaly V |

| 13 | Compiladores | Development | Carlos Erivelton |

| 14 | Criptografia | Cloud Computing | Guimarães |

| 15 | Data Mining | Database | Samantha |

| 16 | Disco Rígido | Hardware | Marcello |

| 17 | DNS | Cloud Computing | Luís Fellipe de Souza |

| 18 | ERP | Software | Esdras |

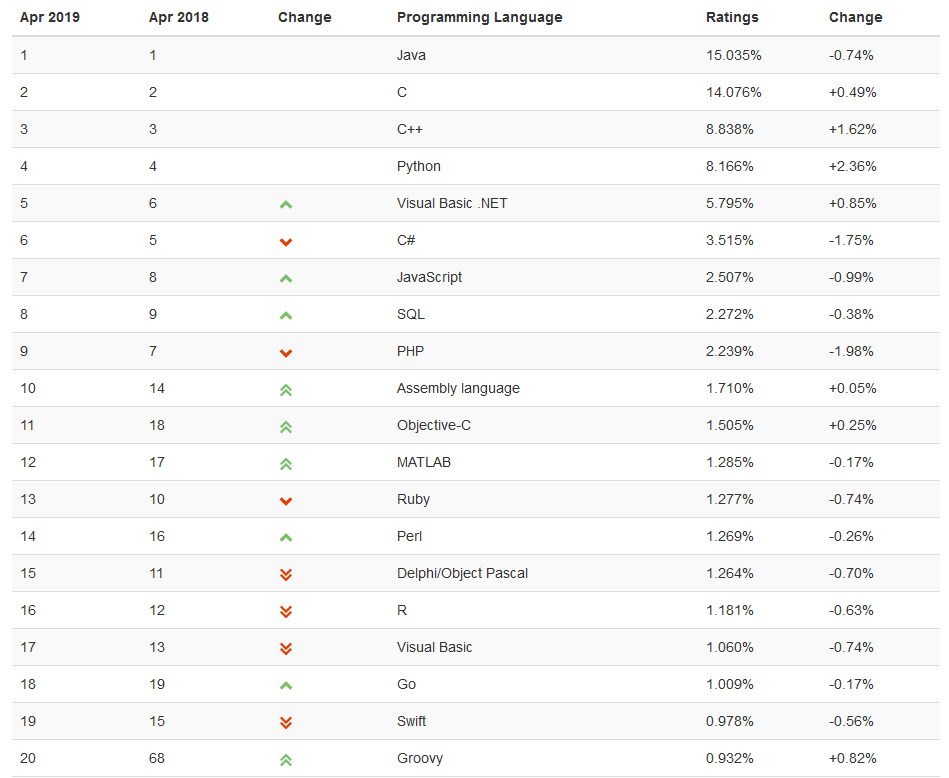

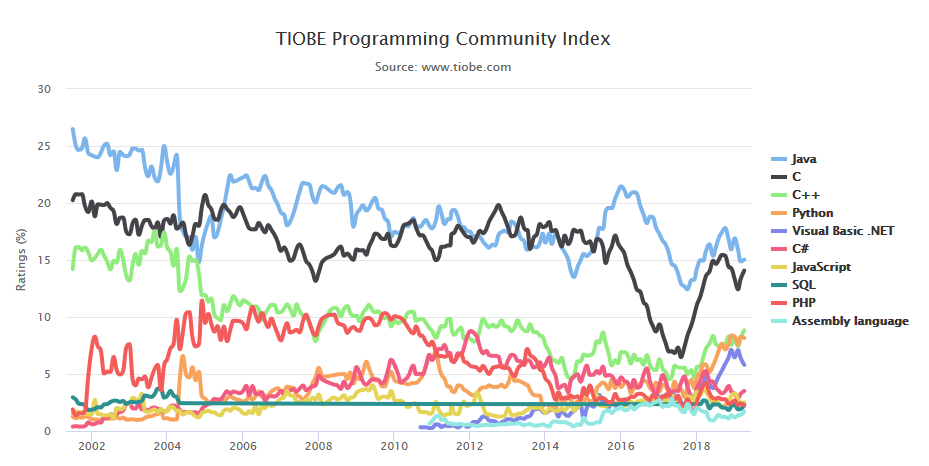

| 19 | ETL | Database | Vinicius Prado |

| 20 | eXtreme Programming | Methods | Murilo Medeiros |

| 21 | FDD | Methods | Francisco dos Santos |

| 22 | Firewall | Net | João Pedro Silva Mendes |

| 23 | Firmware | Software | Pedro Henrique Zardini De Souza |

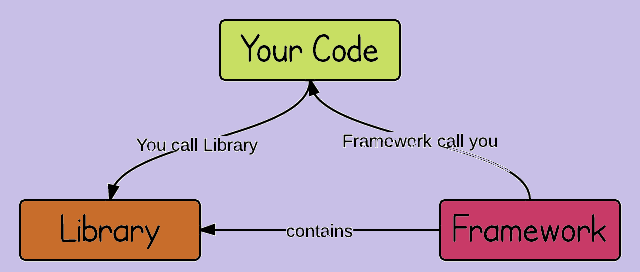

| 24 | Frameworks | Software | Lucas Henrique Couto |

| 25 | IA | State of the Art | Tonus |

| 26 | IDE | Development | Arthur Rodrigues Cardoso |

| 27 | Inteligência Cognitiva | State of the Art | Igor Medeiros |

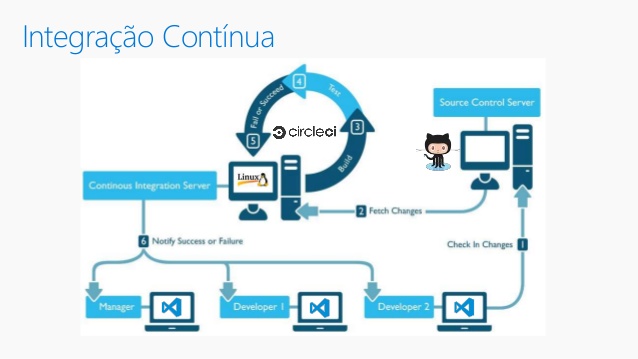

| 28 | Integração Contínua | Methods | Carlos Henrique Duarte de Carvalho |

| 29 | Internet | Net | Brunno Viegas |

| 30 | IoT | Internet of Things | Nicolli Freitas |

| 31 | IP | Net | Gustavo Alves |

| 32 | IPSec | Internet of Things | Piedro Hammer |

| 33 | Linguagens de Programação | Development | Luís Humberto Rodrigues |

| 34 | Machine Learning | State of the Art | Rick Ricarte |

| 35 | Memória RAM | Hardware | Luiz André |

| 36 | Memória ROM | Hardware | Bryan Ernanes |

| 37 | Modelo Orientado a Serviço | Methods | Dyany |

| 38 | Modem | Cloud Computing | Pedro Alexandre |

| 39 | Normalização (BD) | Database | Wilson Santos |

| 40 | NoSQL | Database | João Victor |

| 41 | Open Source | Development | Fernando Daniel Silva |

| 42 | Periféricos | Hardware | Matheus Gonçalves Coelho de Resende Silvano |

| 43 | Plataformas | Cloud Computing | Augusto Cesar de Barros Silveira |

| 44 | Portas | Hardware/Net | Marco Túlio Candeo |

| 45 | Processadores | Hardware | Victor Buiatti |

| 46 | Protocolos | Net | Rafael Dutra |

| 47 | RA | State of the Art | Lucas Mezencio Santana |

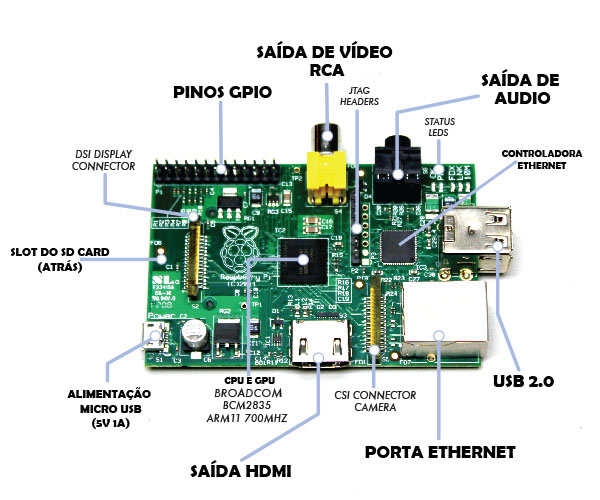

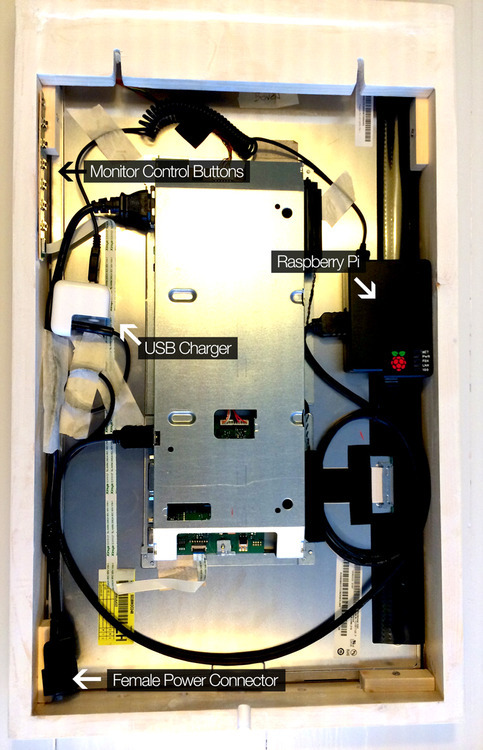

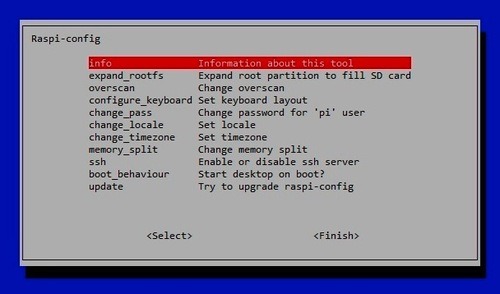

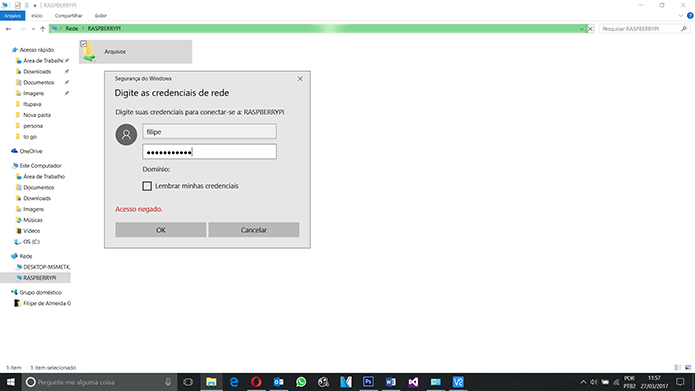

| 48 | Raspberry | Internet of Things | Gabriel Ferreira de Souza |

| 49 | Redes de Computadores | Net | Gabriel Rafah |

| 50 | Redes Neurais | State of the Art | Thalison Henrique |

| 51 | RFId | Internet of Things | Henrique Matheus |

| 52 | Roteador | Net | Tiago Gomes |

| 53 | SaaS | Cloud | Rogério Aguilar Silva |

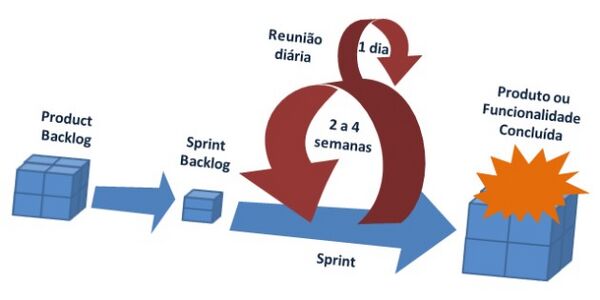

| 54 | Scrum | Methods | Gustavo Augusto Ferreira |

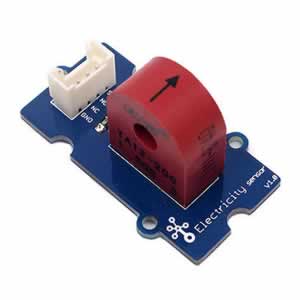

| 55 | Sensores | Internet of Things | Matheus de Camargo Martins |

| 56 | Sistema embarcado | Software | murilo ferreira |

| 57 | SO | Software | Marco Antonio da Silva Rodrigues |

| 58 | Speech Recognition | State of the Art | Igor Lourenço |

| 59 | SQL | Database | Ramon Maximo |

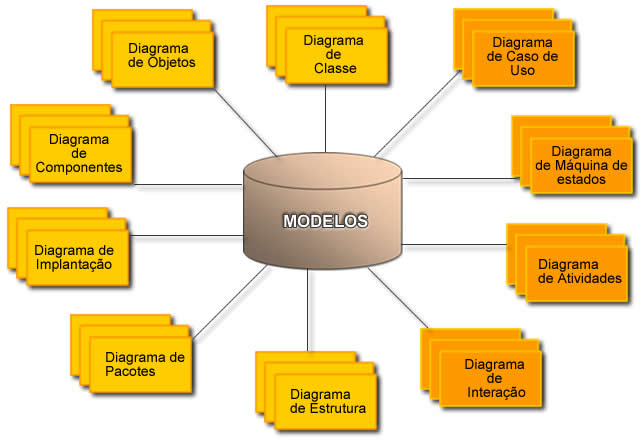

| 60 | UML | Methods | Bruno Giamatei Bertoco |

| 61 | Virtualização | Cloud Computing | Lucas Capra |

| 62 | Web | Software | Gabriel Marques |

| 63 | Webservice | Development | Vinicius Pereira |

Descrição dos temas

Algoritmos

- Noções de Algoritmos

Algoritmo é a base da ciência da computação e da programação. Quando falamos em programar, falamos, basicamente, em construir um algoritmo. Todo programa de um computador é montado por algoritmos que resolvem problemas matemáticos lógicos com objetivos específicos. Mesmo pessoas que usam uma linguagem de programação para fazer seus programas de computadores estão, na realidade, elaborando algoritmos computacionais em suas mentes. Um algoritmo não passa de passos sequenciais e lógicos que são organizados de forma a realizar a conclusão de certo problema. Mas precisamos entender que existem dois tipos de algoritmos, os Não Estruturados e os Estruturados. Programadores usam algoritmos estruturados, pois se adequam a determinado objetivo ou certo fim. Mas não são apenas os programadores que usam algoritmos. Em nosso cotidiano, os algoritmos Não Estruturados são trabalhados em nossas mentes sem nem mesmo percebermos.

- Algoritmos não estruturados

Em nossa rotina, executamos algoritmos sem perceber. Quando você levanta pela manhã, quando você sai de casa, quando almoça. Você está sempre executando tarefas enquanto realiza análises de decisões, análises de possibilidades, valida argumentos e diversos outros processos. Há muitos exemplos de algoritmos. Um deles são os manuais de instruções. Manuais de instruções sempre contêm informações detalhadas sobre o que fazer em cada situação e nos previnem de maiores problemas.

- Algoritmos Estruturados

São aqueles que buscam resolver problemas através do uso de um computador. São criados com base em uma linguagem de programação e podem ser escritos de diversas formas. Um algoritmo pode ser representado pelo chamado Português Estruturado, que é uma ferramenta que usa combinações de sequências, seleções e repetições. São evitados advérbios e adjetivos, formas verbais diferentes da imperativa, muita pontuação e descrição esparsa.

- Bibliografia

https://www.devmedia.com.br/nocoes-basicas-de-algoritmo/26405

API

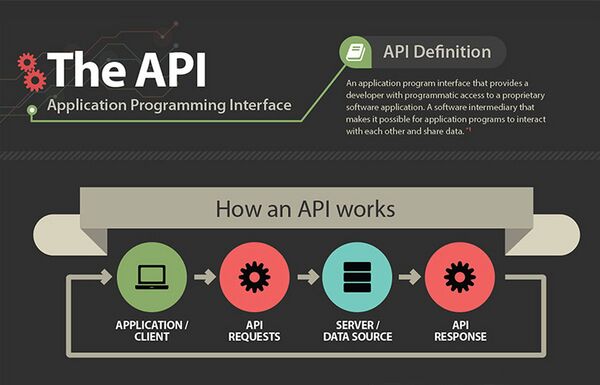

- O que é?

- Segundo o Free Online Dictionary of Computing (1994) API é uma ferramenta que que realiza comunicação entre aplicações que desejam compartilhar suas rotinas, ferramentas, padrões e protocolos.

- Exemplificando de maneira mais simples: É uma espécie de mensageiro entre dois ou mais sistemas, exemplificando de maneira familiar, a API é como um garçom de um restaurante. O cliente, neste caso a aplicação que deseja receber os serviços, recebe do garçom o menu com todos os itens daquele restaurante. Ao escolher uma opção o garçom leva este pedido até a cozinha, aplicação da API, onde por sua vez os cozinheiros, que são os serviços compartilhados pela aplicação, realizam o pedido como foi descrito pelo cliente. Ao concluir o pedido o cozinheiro avisa o garçom, este por sua vez entrega o pedido ao cliente completando o processo de exemplificação uma requisição de API.

- Tipos de API.

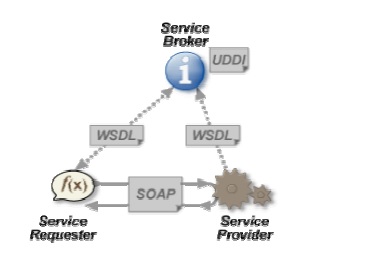

- Atualmente, muitas API são baseadas em Serviços de webresidentes em hipertexto-padrão, as mais utilizadas no momento são as API baseadas em REST e SOAP.

- REST: Os Serviços web RESTful são qualquer serviço do grupo de abordagens que se molda aos princípios da arquitetura de Transferência de Estado Representativo (REST). Os princípios REST pedem uma arquitetura de cliente/servidor stateless geralmente com base em HTTP. Eles se moldam aos Indicadores de Recurso Universal (URI) e usam os métodos CRED de PUT, GET, POST e DELETE.

- SOAP: O Protocolo Simples de Acesso aObjetos (SOAP) baseado em Serviços de Web é baseado no protocolo WC3. O WC3 estabelece que o “SOAP é um protocolo mais leve para a troca de informações em um ambiente descentralizado e distribuído”. Geralmente está associado à Linguagem de Descrição de Serviços Web (WSDL) e UDDI. A WSDL é definida como uma linguagem baseada em XML para descrever os serviços web.

- Como funciona?

- Por que devemos desenvolver e utilizar API.

- Dentre diversos motivos, os principais que podemos citar, de acordo com Luckas Frigo do site Moblee, são:

- 1) Não ficar refém de uma tecnologia ou serviço.

- O primeiro motivo é não ficar refém de uma tecnologia específica. Pode ser a troca de banco de dados, de linguagem de programação ou um serviço de terceiros que pode deixar de existir.

- 2) Centralizar informações e regras de negócio.

- Parece bem óbvio e é a principal função de qualquer API, mas nós já passamos por casos em que o sistema que nós estávamos integrando não tinha uma API. Nós tínhamos acesso direto a um banco de dados. Agora imagina se nós estivéssemos na mesma situação: cada aplicação lendo e escrevendo do jeito ela acha melhor, sem uma API no meio para validar regras e garantir que os dados estão consistentes. Seria o caos.

- 2) Centralizar informações e regras de negócio.

- 3) Aplicar regras de integração customizada

- Gerenciar regras de integração customizadas. Como assim? Principalmente quando você tem um produto white-label, é necessário ter regras de integração diferentes para clientes diferentes. Por exemplo, nós temos um produto que é um leitor de contatos que coleta dados a partir da credencial do participante. Por isso, nós temos que integrar dados com diversos sistemas de credenciamento para conseguir conectar a informação da credencial com os dados do participante. Nesse processo, é bem comum acontecerem mudanças de última hora no formato do código da credencial. Como o processo de republicar um app é relativamente lento, não é possível garantir que todos os usuários estejam com a versão mais atualizada e fica a cargo da API conseguir contornar essas situações.

- 3) Aplicar regras de integração customizada

- 4) Autenticar o usuário em sistemas diferentes

- Como eu já citei, nosso produto é white-label e se integra com vários sistemas dependendo de cada cliente. Às vezes, não basta que o usuário faça login na nossa base, é preciso autenticá-lo no sistema do cliente também. Imagine ter que ensinar o seu app a se logar em cada sistema. Agora imagine se alguma regra de autenticação do sistema do cliente muda após o app já estar publicado. Seria uma dor de cabeça ter que republicar todos os aplicativos que dependem dessa integração. Por isso, contar com a API ajuda a manter a consistência das chamadas que o app faz e diminui a chance da sua republicação.

- 4) Autenticar o usuário em sistemas diferentes

- 5) Segmentar informações

- Existem vários casos em que você precisa segmentar informações de acordo com a aplicação que está solicitando-a. O CMS, por exemplo, precisa de informações que os apps não precisam. Eventualmente, pode ser preciso diferenciar informações para usuários de Android ou iOS. O envio de notificações é um caso de exemplo bem comum. Se precisamos publicar algum tipo de atualização crítica no app iOS e notificar aos usuários, não é necessário que os usuário de Android também recebam essa notificação. Essas regras de segmentação de informação quem cuida é a API.

- 5) Segmentar informações

- 6) Internacionalizar

- Internacionalizar costuma ser um problema para quem está crescendo internacionalmente. Nós temos aplicativos publicados em vários países e em várias línguas: português, inglês, espanhol… até mesmo tailandês. Independente de utilizar uma solução pronta de API ou ter a sua própria API, ela ajuda a manter a consistência entre dados internacionalizados. É bem comum acontecer dos nossos cliente traduzirem uma parte do conteúdo e deixar partes sem tradução. A API nos ajuda a manter a consistência, entregando a informação numa língua padrão, caso aquela informação não tenha sido ou não precise ser traduzida.

- 6) Internacionalizar

- 7) Dar suporte a versão antiga do app

- Quem nunca passou por isso, um dia vai passar. Continuamente sua aplicação vai ganhar novas funcionalidades e novas regras de negócio. O aplicativo dos usuários que não atualizarem para a última versão pode ficar inutilizável se a API não souber lidar com essas mudanças. Como você não controla quais usuários de fato fizeram atualização, fica difícil gerenciar esse tipo de coisa sem ter uma API responsável, pois é ela que mantém a consistência das regras de negócio.

- 7) Dar suporte a versão antiga do app

- 8) Controlar o endpoint

- Mesmo que você use um serviço como o Firebase por trás da sua API, é importante que você controle o endpoint, ou seja, a URL pela qual suas aplicações acessam a API. Isso reflete tanto a dependência de serviços de terceiros, quanto o suporte à atualização que comentamos.

- 8) Controlar o endpoint

- Referências Bibliográficas

App

- Conceito

- Aplicativo é um software que executar sequencias de comandos para realizar determinado objetivo pela qual foi projetado em um smartphone ou tablet.

- Ações executadas por aplicativos em sua maioria são para agilizar algum processo, diminuir custos ou substituir mão de obra.

- Aplicativos podem ser nativos ou híbridos.

- Aplicações nativas

- É aquele aplicativo que foi projetado para determinada plataforma. Ex: Android e IOS.

- Pode explorar o máximo do sistema operacional para qual foi desenvolvido.

- Caso o aplicativo tenha a necessidade ser executado em duas plataformas mobile (Android e IOS), então deve ser desenvolvido para cada plataforma separadamente.

- É uma ótima opção para clientes que desejam mais confiabilidade, segurança e comunicação direta com as funcionalidades do sistema operacional.

- Aplicações híbridas

- São aqueles aplicativos desenvolvidos tanto com códigos nativos quanto web, ou seja, podem desfrutar de recursos da internet e do sistema na qual está sendo executado.

- Não podem usar funcionalidades do dispositivo, sendo necessário o intermédio de um framework para ser possível a utilização de funcionalidades como por exemplo GPS e câmera.

- São mais rápidos e tem um custo de desenvolvimento menor do que aplicativos nativos. O tempo e custo reduzido é justificado pelo fato de ser necessário desenvolver aplicação apenas uma vez, já que o software roda em qualquer plataforma.

- Ferramentas de desenvolvimento

- Para o desenvolvimento dessas aplicações são utilizados algumas ferramentas como: editor de texto, IDE, framework, API, compilador, etc.

- Para desenvolver aplicações mobiles são utilizados em sua maioria IDEs e frameworks para agilizar e facilitar o processo de desenvolvimento.

- Ferramentas mais utilizadas

- Xamarin

- Android Studio

- Ionic

- React Native

- Unity

- Xcode

- Referências bibliográficas

Arduino

- O que é?

No site oficial da Arduino, encontramos a seguinte definição (traduzida): O Arduino é uma plataforma de código aberto (Logo, possui possui tanto hardware quanto software open source! expressão utilizada para denotar que o mesmo pode ser executado, copiado, modificado e redistribuído pelos usuários de forma livre) de prototipagem eletrônica com hardware e software flexíveis e fáceis de usar, destinado a artistas, designers, hobbistas e qualquer pessoa interessada em criar objetos ou ambientes interativos. Em termos simples, as placas Arduino são semelhantes à um minicomputador, no qual, pode-se programar a maneira como suas entradas e saídas devem se comportar em meio aos diversos componentes externos que podem ser conectados nas mesmas. Essas placas são plataformas essencialmente formadas por dois componentes: A placa, que é o Hardware que usaremos para construir nossos projetos e a IDE Arduino, que é o Software onde escrevemos o que queremos que a placa faça.

E agora a pergunta... Por que essa plataforma de desenvolvimento é tão usada? A maior vantagem dessa plataforma sobre as demais é a sua facilidade de utilização, pois, pessoas que não são da área técnica podem aprender o básico e criar seus próprios projetos em um intervalo de tempo relativamente curto.

- Como surgiu?

O Arduino foi um projeto que iniciou na Itália no ano de 2005 com o objetivo de ser uma plataforma de baixo custo e de fácil aprendizado, pois antigamente para se confeccionar um circuito interativo, era necessário fazer projetos do zero para uma aplicação específica. Além disso, para se fazer pequenas alterações nas funcionalidades do circuito era necessário um estudo crítico e bastante trabalho. Com a criação dos microcontroladores, foi possível que problemas que antes eram tratados com soluções de hardware fossem tratados usando software de computadores. Dessa forma, um mesmo circuito poderia desempenhar funções totalmente diferentes, através da reprogramação e alteração de alguns parâmetros do programa. No entanto, apesar da facilidade trazida pelos microcontroladores, trabalhar com os mesmos não era tão fácil. Desta forma, um grupo de pesquisadores italianos teve a ideia de fazer um dispositivo que tornasse o seu uso simples e acessível a qualquer um. O resultado foram as placas Arduino. Os desenvolvedores são: Massimo Banzi, David Cuartielles, Tom Igoe, Gianlica Martino e David Mellis.

- Como funciona?

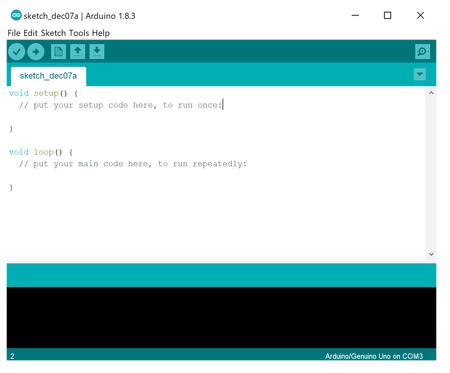

Como já dito, os Arduinos possuem funcionamento semelhante ao de um pequeno computador capaz de interpretar entradas e controlar as saídas afim de criar sistemas automáticos. Para isso, você precisa programa-lo ou seja, falar ao controlador quais decisões devem ser tomadas em cada circunstância. Para isso, escrevemos um código que segue uma sequência lógica de tomada de decisões que leva em conta as variáveis que serão lidas e/ou controladas. Para programar essas placas, ou seja, ensiná-las a desempenharem a as funcionalidades que você deseja, basta utilizarmos a sua IDE (ambiente integrado de desenvolvimento), que por sua vez, é um software onde podemos escrever um código em uma linguagem denomidada Wiring, semelhante a C/C++, o qual, será traduzido, após a compilação, em um código compreensível pela nossa placa.

- Aonde podemos usá-lo? Quais são as aplicações possíveis?

Por exemplo, um uso simples de Arduino seria acender LED's (imagine aqueles usados na época de natal) de maneira alternada à criar um certo padrão. Nesse exemplo, o Arduino teve vários LED's e um botão conectados a ele. O circuito aguardaria até que o botão fosse pressionado, de modo que, uma vez pressionado o botão, ele acenderia os LED's fazendo os padrões estipulados no código.

Outro exemplo mais simples ainda, seria ligar uma lâmpada, funcionamento que poderia ser posteriormente estendido, por exemplo pela conexão de um sensor, como um sensor de movimento, para acender a lâmpada quando uma pessoa entrasse em um determinado local e a desligasse quando a pessoa saísse do mesmo. O que faria o processo de lâmpadas ligarem e desligarem, automaticamente! Imagine uma casa onde não houvesse interruptores e sim uma "rede de Arduinos" controlando todas as luzes... Outros inúmeros projetos podem ser feitos com essa plataforma, como um painel solar que se move de acordo com a incidência da radiação proveniente do sol, aumentando assim a produção energética; uma planta que manda uma mensagem no seu celular quando precisar ser regada, uma caixa de brinquedos aberta por leitura de impressão digital, um robô espião sem fio entre muitos outros. A imaginação é o limite!

- Quais os modelos mais famosos de placas Arduino?

Erro ao criar miniatura: Arquivo não encontrado

Existem muitos modelos de placas Arduino, mais muitos mesmo! A mas a mais popular é a Placa Arduino Uno que iremos usar como referência. Apesar de diferentes modelos, os projetos que programamos em um modelo podem ser facilmente adaptados para outro. Basta ficar atento para as particularidades de cada placa.

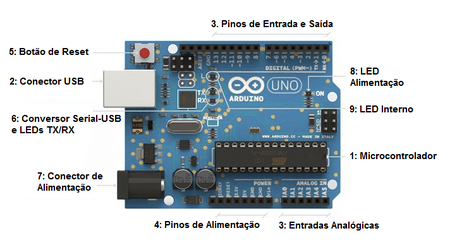

- Arduino Uno e seus componentes:

Microcontrolador: Microcontrolador: Esse é o cérebro do Arduino. Um computador inteiro dentro de um pequeno chip. Este é o dispositivo programável que roda o código que enviamos à placa.Existem várias opções de marcas e modelos de microcontroladores, nessas placas foram adotados os microcontroladores da Microchip, que inicialmente eram produzidos pela Atmel, mas especificamente a linha ATmega. O modelo UNO, por exemplo, usa o microcontrolador ATmega328.

Conector USB: Conecta a placa ao computador. É por onde o computador e o Arduino se comunicam com o auxílio de um cabo USB, além de ser uma opção de alimentação da placa.

Pinos de Entrada e Saída: Pinos que podem ser programados para agirem como entradas ou saídas fazendo com que o Arduino interaja com o meio externo. O UNO R3 possui 14 portas digitais (I/O), 6 pinos de entrada analógica e 6 saídas analógicas (PWM).

Pinos de Alimentação: Fornecem diversos valores de tensão que podem ser utilizados para energizar os componentes do seu projeto. Devem ser usados com cuidado, para que não sejam forçados a fornecer valores de corrente superiores ao suportado pela placa.

Botão de Reset: Botão que reinicia a placa.

Conversor Serial-USB e LEDs TX/RX: Para que o computador e o microcontrolador conversem, é necessário que exista um chip que traduza as informações vindas de um para o outro. Os LEDs TX e RX acendem quando o Arduino está transmitindo e recebendo dados pela porta serial respectivamente.

Conector de Alimentação: Responsável por receber a energia de alimentação externa, que pode ter uma tensão de no mínimo 7 Volts e no máximo 20 Volts e uma corrente mínima de 300mA. Recomenda-se 9V, com um pino redondo de 2,1mm e centro positivo. Caso a placa também esteja sendo alimentada pelo cabo USB, ele dará preferência à fonte externa automaticamente.

LED de Alimentação: Indica se a placa está energizada.

LED Interno: LED conectado ao pino digital 13.

Especificações da placa: Nesta placa o microcontrolador ATmega328 é utilizado, este dispõem de 32kb de memória flash e 2kb de SRAM. De maneira simples a memória flash é o local na qual nosso programa será salvo, já a SRAM é a memória na qual nossas variáveis serão salvas. A diferença básica entre esses dois tipos de memória é que a flash não perde seus dados caso o Arduino seja desligado ou reiniciado o mesmo não é válido para a SRAM.

- IDE Arduino:

Uma das grandes vantagens da plataforma Arduino está no seu ambiente de desenvolvimento, que usa uma linguagem baseada no C/C++, linguagem bem difundida, usando uma estrutura simples. Mesmo pessoas sem conhecimento algum em programação conseguem, com pouco estudo, elaborar programas rapidamente.

- Fontes de pesquisa:

- <https://edisciplinas.usp.br/mod/resource/view.php?id=1645987> Artigo Acadêmico

- <http://www.abenge.org.br/cobenge/arquivos/8/sessoestec/art1886.pdf>Artigo Acadêmico

- <https://www.arduino.cc> Site Ofical do Arduino

- <https://portal.vidadesilicio.com.br/o-que-e-arduino-e-como-funciona/>

Banco de Dados

- O que é?

- Um banco de dados é uma forma de armazenar informações em disco de uma forma estruturada. Banco de dados são conjuntos organizados de dados, que se relacionam com outros para criar uma informação e dar mais eficiência durante uma pesquisa ou estudo. Atualmente, os bancos de dados são a principal parte de um sistema de informação, pois é nele que está toda a informação que o sistema é alimentado. Os bancos costumam perdurar por vários anos ou até décadas sem alteração na sua estrutura. A principal aplicação é no controle de operações empresariais e no gerenciamento de informações de estudos.

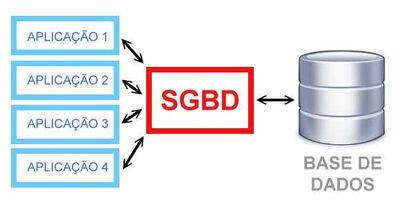

- Principais ferramentas:

- Sistemas Gerenciadores de Banco de Dados (SGBD’s) ou em inglês Data Base Management System (DBSM), que como o nome sugere, são softwares de Gerenciamento de Banco de Dados, que são utilizados pelos programadores ou DBA’s, para consultar os bancos de dados. Com a evolução desses softwares, vários modelos de armazenamento de dados foram criados, como o Modelo hierárquico, Modelo em rede, modelo orientado a objetos e outros, cada um com suas particularidades, vantagens e desvantagens.

- Abstração de dados

- O sistema de banco de dados deve oferecer uma visão abstrata dos dados que lá estão armazenados, por exemplo, o usuário não precisa saber qual criptografia está sendo usada ou se está sendo usada, ele não precisa saber a normalização do banco, ele não precisa saber qual unidade de armazenamento está sendo utilizada, contando que quando ele precisar o dado esteja disponível para ele quando precisar. A abstração se dá em 3 níveis:

- Nível de visão do usuário: as partes do banco que o usuário tem acesso, de acordo com a necessidade individual.

- Nível Conceitual: aqui é definido quais dados estão armazenados, e qual o relacionamento entre eles.

- Nível físico: aqui define efetivamente como os dados estão armazenados, o nível mais baixo de abstração.

- Projeto de Banco de Dados

- Todo sistema de banco de dados deve apresentar um projeto da forma que os dados estão sendo armazenados a sua organização, e as técnicas utilizadas na produção do banco, para que no futuro facilite as possíveis manutenções. Esse projeto de banco de dados se dá em duas partes: projeto lógico e modelo conceitual. Essas fases são aplicadas na documentação de um banco de dados não implementado, no caso de ser um banco de dados já implementado, é utilizado a técnica de engenharia reversa para deduzir quais as técnicas que foram utilizadas para a produção desse banco.

- Referências bibliográficas

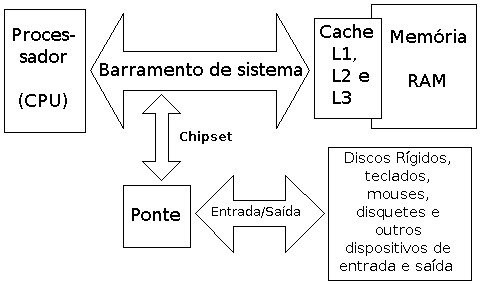

Barramentos

- É um conjunto de linhas de comunicação que permitem a interligação entre dispositivos, como a CPU, a memória e outros periféricos. Os barramentos podem ser chamados também de interfaces, portas, conectores, slots. Com a evolução do computador surgiram vários outros tipos de barramentos: USB, Firewire, Tunderbolt, Serial, PS/2, SuperVideo/VGA/HDMI. Os processadores mais modernos, sejam da Intel ou da AMD, possuem um barramento extremamente rápido para se comunicarem com a memória e assim transferirem dados sem perda de desempenho.

- Funções

- Comunicação de Dados: função de transporte dos dados. Tipo bidirecional;

- Comunicação de Endereços: função de indicar endereço de memória dos dados que o processador deve retirar ou enviar. Tipo unidirecional, e;

- Comunicação de Controle: função que controla as ações dos barramentos anteriores. Controla solicitações e confirmações. Tipo bidirecional.

- Tipos de Barramentos.

- Na arquitetura de computadores são caracterizados como síncronos e assíncronos.

- Barramento Sincrono:

- Barramento do Processador: É utilizado pelo processador internamente e para envio de sinais para outros componentes do sistema computacional.Atualmente, os barramentos dos processadores (os de transferência de dados) têm sido bastante aprimorados com o objetivo de maior velocidade de processamentos de dados.

- Barramento de Cache: É o barramento dedicado para acesso à memória cache do computador, memória estática de alto desempenho localizada próximo ao processador.

- Barramento de Memória: É o barramento responsável pela conexão da memória principal ao processador. É um barramento de alta velocidade que varia de micro para micro e atualmente gira em torno de 512 MHz a 8192 MHz, como nas memórias do tipo DDR3.

- Barramento de Entrada e Saída: É o barramento I/O (ou E/S), responsável pela comunicação das diversas interfaces e periféricos ligados à placa-mãe, possibilitando a instalação de novas placas, os mais conhecidos são: PCI, AGP e USB.

- Barramento de Dados: É o barramento Data Bus, responsável por transportar informação da instrução (através do código de operação), variável do processamento (cálculo intermediário de uma fórmula por exemplo) ou informação de um periférico de E/S (dado digitado em um teclado). O tamanho da via de dados determina respectivamente o máximo número de instruções (e portanto o potencial de processamento) e a precisão do processamento aritmético (através do cálculo de ponto flutuante) ou o número de símbolos possíveis a ser representado (por exemplo, pontos de uma foto).

- Barramentos assíncronos:

- Os barramentos assíncronos não possuem clock e por sua vez adotam um protocolo chamado de "aperto de mão" ou handshake para estabelecer a comunicação entre os dispositivos assim podendo ser mais adaptável a dispositivos novos ou lançamentos pois ele não possui velocidade fixa.

- Referências

https://americnet.wordpress.com/2010/03/18/tipos-de-barramentos-do-computador/ https://pt.wikipedia.org/wiki/Barramento https://www.hardware.com.br/livros/hardware/barramentos.html https://canaltech.com.br/hardware/O-que-e-um-barramento/ Infraestrutura de Hardware –Juliana Regueira Basto Diniz, Abner Corrêa Barros - Volume 2

BigData

Atualmente na informatica trabalhamos com uma amplitude gigante de dados, um sistema pode receber inúmeras informações (caso seja programado para tal) como quanto tempo o cursor ficou parado em um local, quanto tempo o usuário ficou em uma página. Essa chuva de informações podem ser importantes ou não, desse ponto de ideia surgiu o conceito de Big Data.

Big Data nada mais é do que a analise dos dados brutos gerados por um sistema para assim serem filtradas (garimpadas) as mais "importantes" , essas em menor volume e mais fáceis de serem trabalhadas.

Dentro das analises para Big Data existem 5 aspectos importantes a serem destacados, são eles velocidade, veracidade, valor, volume e variedade. O volume é a quantidade de dados a serem analisados (sempre em crescimento), a velocidade que os dados vão sendo gerados, a variedade de vários lugares onde os dados serão gerados, veracidade da informações, pois dependendo do local onde é gerado ou o tempo ela pode não ser mais verdade, por ultimo e talvez a mais importante seja o valor, qual a importância de um dos dados para meu sistema ou podem ser reaproveitamos em outro local, neste caso qual deve ser descartado ou guardado.

Muitas empresas acabam lucrando com a venda desses dados filtrados através de Big Data, um exemplo hipotético pode ser a Spotify vender informações onde um cantor é mais ouvido ou não, o cantor pode fazer um show onde é mais popular e investir em divulgações onde menos é ouvido. Muitas redes sociais trabalham com a Big Data para mostrar o que seu usuário quer ver.

- Referencias Bibliográficas

BlockChain

- O que é?

- Blockchain, uma das tecnologias por trás do Bitcoin, a maior criptomoeda já inventada. Basicamente um banco de dados online, público e descentralizado, criado para tornar a distribuição de informações transparente e confiável, não dependendo assim de um agente externo e/ou centralizador que valide o processo.

- Rede Peer-to-Peer (P2P)

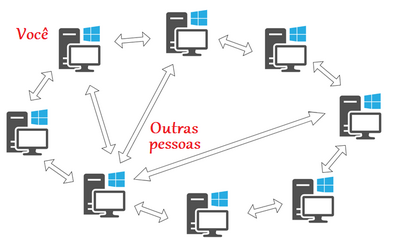

- Formado por uma rede de computador interligados, conhecido como rede peer-to-peer. Cada criptomoeda possui sua própria Blockchain. Como dito antes, a tecnologia Blockchain é formada por uma rede peer-to-peer, que é nada mais que uma arquitetura de redes de computadores onde cada um dos pontos ou nós da rede funciona tanto como cliente quanto como servidor, permitindo compartilhamentos de serviços e dados sem a necessidade de um servidor central, como pode ser visto na imagem abaixo.

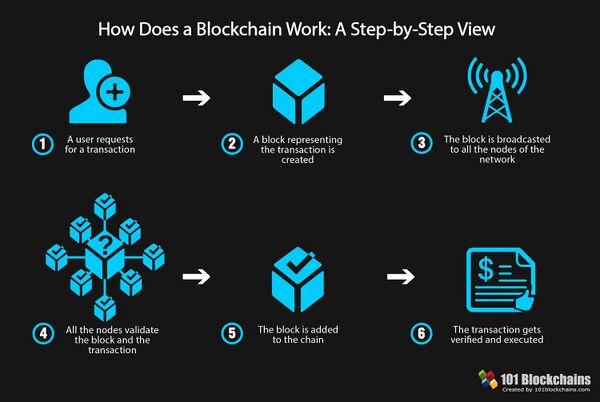

- Como funciona?

- Nesta tecnologia revolucionaria, os computadores da rede são responsáveis por validar as transações. No caso do Bitcoin, toda vez que uma transação é realizada, é verificada pelos membros da rede registrada no blockchain correspondente. Por intervalos regulares de tempos (o tempo varia sobre as criptomoedas, no caso da bitcoin, 10 minutos), essas novas transações são reunidas em blocos, criptografadas e adicionadas a uma cadeia de blocos (blockchain) que guarda e registra também as transações passadas.

- Vantagens

- Eliminação de troca por intermediário e falta de confiança;

- Empoderamento dos usuários;

- Alta qualidade de dados;

- Durabilidade, confiabilidade e longevidade;

- Integridade de processo;

- Transparência e imutabilidade;

- Simplificação de ecossistema;

- Transações mais rápidas;

- Menor custo por transação;

- Digital.

- Desvantagens

- Tecnologia nascente;

- Estado regulatório instável;

- Grande consumo de energia;

- Controle, segurança e privacidade;

- Questões de integração;

- Adoção cultural;

- Custo;

- Referencias Bibliográficas

Bots

- Bots são tipos específicos de programas de computadores implantados em outros sistemas para automatizar partes do funcionamento de um todo, realizando as tarefas de forma autônoma desde facilitar a navegação na internet até interagir com indivíduos, feito a partir de algoritmos que foram programados anteriormente. Os Bots são divididos em áreas dependendo do que fazem no programa, tem diversos e usados de formas variadas, como os crawlers, os chatbots e até usado em videogames

- Os conceitos para a realização desses softwares se iniciaram com Alan Turing ,que ,em 1950, definiu um conceito comum para o que seria Inteligência Artificial que até então era inexistente. Alan Turing elaborou então um teste que até hoje é utilizado para confirmar se uma máquina é ou não uma IA, o teste se baseava em um dialogo entre um ser humano e uma máquina e depois de algumas perguntas e respostas o ser humano não conseguisse distinguir que estava dialogando com uma máquina, tal poderia ser considerada verdadeiramente uma IA.

- Os Chatbots ferramentas software capazes de propor um diálogo com o ser humano em linguagem natural que foram fundamentados através do teste de Turing, o dialogo se desenvolve através da capacidade de compreensão do sistema e da simulação do comportamento humano. A concepção mais aceitada sobre os chatbots seria de Simon Laven que diz " ... um programa que tenta simular uma conversa escrita, e que tenta, pelo menos temporariamente, se parecer com um ser humano". Com isso percebemos que os objetivos dos chatbots e da IA, estão conectadas, no que se refere na proximidade com o comportamento humano.

- Os crawlers são programas automatizados e metódicos que faz downloads de páginas WEB para criar índices ou caches sobre as mesmas. É aplicado em diversas áreas desde obter informações até mesmo mapear uma gama de sites, sendo muito utilizado por empresas que possuem motores de busca em sites, como o Google e o Mozila Firefox.

- Fontes:

http://www.inf.ufsc.br/~luis.alvares/INE5644/G1_WebCrawlers.pdf

http://www.cin.ufpe.br/~tg/2016-2/jhcl.pdf

http://www.internetlab.org.br/wp-content/uploads/2018/07/Relat%C3%B3rio-Bots-ou-n%C3%A3o.pdf

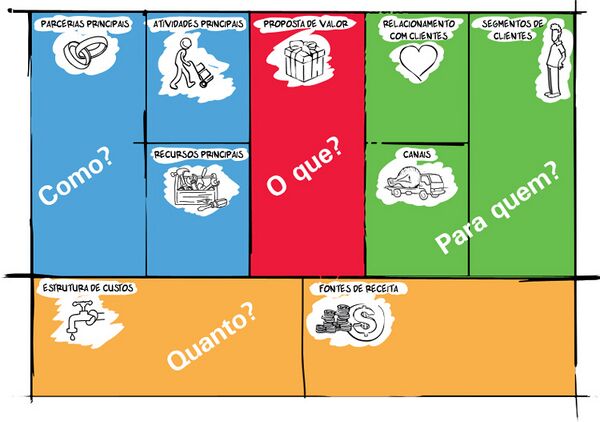

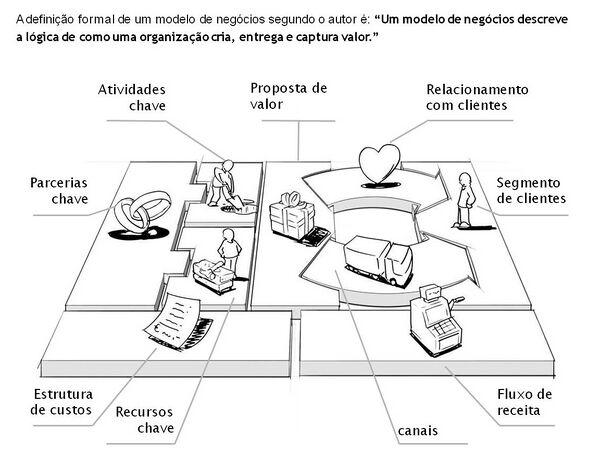

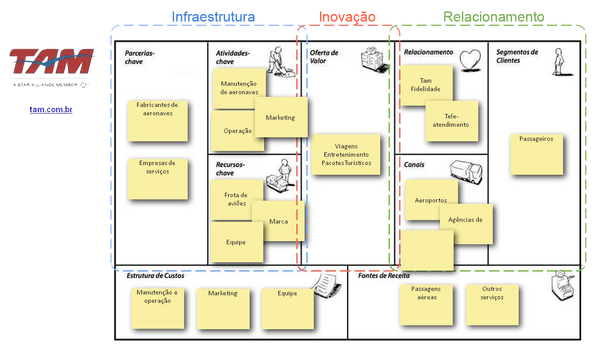

Canvas

- O Business Model Canvas é uma ferramenta estratégica que contribui de forma significativa para a construção rápida e visual de novos produtos ou serviços. Sua aplicação consiste no uso de um painel dividido em nove grandes blocos, como mostra a figura abaixo, que representam os elementos fundamentais (building blocks) que compõem um modelo de negócio.

- O objetivo central do preenchimento do painel é extrair propostas de valor que atendam e potencializem os principais objetivos desejados do negócio, antes de partir de fato para a formatação do produto ou serviço.

- Abaixo apresentamos a dinâmica de montagem do Modelo Canvas sugerida por Osterwalder.

- Para aplicar o Canvas, pode-se utilizá-lo impresso em um tamanho A4 ou A3 para facilitar o trabalho colaborativo; ou desenhá-lo em um quadro, pois seu layout é simples de ser replicado. Para preencher o Canvas é recomendado utilizar post-its, pois são fáceis de manipular.

- O Canvas, que apresentamos na figura abaixo, pode ser subdividido em duas grandes dimensões, como nos lados direito e esquerdo do cérebro, sendo a dimensão mais à direita os elementos mais subjetivos e "emocionais" e os elementos da parte esquerda os mais estruturais e lógicos. Sugere-se preencher o Canvas da direita para a esquerda, pois assim é possível conhecer primeiro os anseios e desejos dos envolvidos para, em seguida, começar a defini-los de forma mais concreta.

- Segmentos de Clientes

- Começamos preenchendo o bloco Segmentos de Clientes (Customers Segments), buscando mapear para quem se está criando valor e quem são os potenciais clientes para os objetivos pretendidos.

- Exemplos de segmentos de clientes:

- Consumidores da classe C

- Mulheres

- Idosos

- Consumidores de uma cidade

- etc.

- Proposta de Valor

- No bloco Proposta de Valor (Value Proposition) são criadas propostas que atendam a determinadas necessidades dos potenciais clientes, sempre tendo os objetivos de negócio norteando a dinâmica.

- Exemplo de propostas de valor:

- Conveniência

- Personalização

- Apoio a decisão

- Rapidez

- Redução de custos

- entre outros.

- Os Segmentos de Clientes e as Propostas de Valor são os principais elementos, sobre os quais todo o restante do Canvas se apoiará.

- Canais de Distribuição

- Uma vez que já se tem uma prévia de clientes potenciais e propostas de valor, é necessário pensar em como fazer com que estes dois elementos fundamentais se encontrem.

- Logo, são definidos e sugeridos os Canais de Distribuição (Channels), como:

- Entrega à domicílio

- Site de conteúdo

- Newsletter

- Atendimento presencial

- entre outros

- através dos quais será possível distribuir e entregar as propostas de valor.

- Uma vez que já se tem uma prévia de clientes potenciais e propostas de valor, é necessário pensar em como fazer com que estes dois elementos fundamentais se encontrem.

- Relacionamentos com os Clientes

- Também é preciso entender como se dará os Relacionamentos com os Clientes (Customer Relationships), que deve ter o propósito de fortalecer o envolvimento do cliente com o negócio.

- São exemplos de relacionamentos com clientes:

- Canal de perguntas e respostas

- Ouvidoria

- SAC

- Atendimento pós-venda

- Serviços automatizados.

- Receita

- Por fim, na dimensão direita, temos as Linhas de Receita (Revenue Stream), que registram como a solução em construção pretende gerar receitas, tendo como base as propostas de valor sugeridas.

- Alguns exemplos:

- Venda de assinaturas mensais

- Venda direta

- Retorno em publicidade paga

- Aluguel.

- Recursos-Chave

- Na dimensão esquerda do Canvas encontramos algumas definições mais objetivas, que irão sustentar os elementos mapeados na dimensão direita.

- Os Recursos-Chave (Key Resources) são os recursos ligados diretamente ao funcionamento do modelo de negócio.

- Podem ser:

- Equipes

- Máquinas

- Investimentos

- Plataformas de tecnologia

- Atividades-Chave

- As Atividades-Chave (Key Activities) são todas as atividades sem as quais não seria possível atender as propostas de valor, construir os canais necessários e manter os relacionamentos.

- Podem ser atividades-chave:

- Acompanhar redes sociais (uma atividade interessante para contribuir com o relacionamento com os clientes)

- Construir uma loja (que pode se relacionar com as propostas de valor e canais específicos)

- Aprender uma tecnologia que serve de base para o desenvolvimento de uma solução

- Monitorar outras soluções para avaliar se a sua está dentro dos padrões;

- Parceiros-Chave

- Já os Parceiros-Chave (Key Partners) são todos aqueles que podem contribuir tanto com as Atividades-Chave quanto com os Recursos-Chave.

- Algumas parcerias:

- Fornecedores de Tecnolologia, podem disponibilizar máquinas para atender a algum Recurso-Chave.

- Algumas parcerias podem contribuir com pessoas ou realizando diretamente alguma das Atividades-Chave, como Monitorar redes sociais

- Outras podem fornecer uma plataforma que se conecta com a sua para prover o serviço final.

- Custos

- Representando os custos necessários para se manter e construir toda a solução proposta, há o bloco Estrutura de Custos (Costs Structure), que indica, por exemplo:

- a necessidade de se Pagar a manutenção das máquinas previstas,

- Pagamentos dos parceiros contratados,

- Custo recorrente de infraestrutura

- Custo das equipes envolvidas

- e assim por diante.

- Representando os custos necessários para se manter e construir toda a solução proposta, há o bloco Estrutura de Custos (Costs Structure), que indica, por exemplo:

- Exemplo de projeto:

- Referências bibliográficas:

- A Osterwalder, Y Pigneur, G Bernarda, A Smith - 2014 - books.google.com

- Professor Dale Brant

Cloud Computing

- Definição

- Cloud Computing ou Computação em nuvem é um termo para descrever um ambiente de computação baseado em uma imensa rede de servidores sejam estes virtuais ou físicos. Uma definição simples pode ser "um conjunto de recursos como capacidade de processamento, armazenamento, conectividade, plataformas, aplicações e serviços disponibilizados na Internet". O significado de nuvem hoje é certamente ligado a um lugar onde se pode armazenar dados e onde aplicações podem usar recursos computacionais da nuvem ou elas podem ser executadas lá.

- Vantagens

- Elasticidade: a computação em nuvem oferece elasticidade permitindo que as empresas usem o recurso na quantidade que forem necessários, aumentando e diminuído a capacidade computacional de forma dinâmica.

- Pagamento: o pagamento dos serviços em nuvem é pela quantidade de recurso utilizados (pay-per-use). Nesse estilo de pagamento a conta é cobrada de acordo uso de dados e com o número de acessos que seus dados armazenados na nuvem foram usados.

- Comodidade: muitas empresas utilizam da computação em nuvem para evitar a dor de cabeça de ter um data center próprio e seus próprios servidores, sendo assim tendo que se preocupar com detalhes como segurança, preservação, manutenção dos servidores.

- Segurança: a segurança da empresas que oferecem serviços de computação em nuvem utilizam de vários métodos de segurança, valendo destacar entre eles os backups das informações. Uma analogia interessante de se fazer seria com um banco, "Você entrega seu dinheiro pra o banco pois sabe que ele estará mais seguro no banco de que com você e quando necessita dele é só ir saca-lo"

- Referências bibliográficas:

- https://books.google.com.br/books?hl=pt-BR&lr=lang_pt&id=mvir2X-A2mcC&oi=fnd&pg=PA1&dq=cloud+computing+&ots=CaJo6HLNUq&sig=zC8_RdJfBYXgHZVU-LjeNiMeLQI#v=onepage&q&f=true

- http://seer.upf.br/index.php/rbca/article/view/3084

CLP

- O que é CLP ?

CLP é a sigla ara Controladores Lógicos Programados ou Programmable Logic Controllers (PLC) em inglês, são computadores responsáveis por executar funções especificas utilizando um programa carregado. CLPs se assemelham muito com Computadores comuns, porem são desenvolvidos para operar em ambientes agressivos, suportando vibrações, poeira e outras condições que poderiam danificar uma CPU normal, alem de permitir várias inserções de módulos de entrada e saída. Basicamente ele opera utilizando sinais analógicos ou digitais, sensores, módulos, chaveamentos, entre outros e sua estrutura é composta por 4 patamares: entradas e saídas, CPU, Backplane ou Rack com fonte de alimentação e seção de programa e é composto por CPI, Memoria RAM e RUN e Portas de Comunicações (COM).

- Sinais analógicos e digitais

Sinais digitais são sinais que possuem apenas 2 (duas) variações de status (botões que permitem que o aparelho seja ligado ou desligado por exemplo), são sinais mais simples também chamados de contínuos por serem específicos e darem resultados previsíveis. Já os sinais analógicos possuem uma configuração mais complexa que permite um status variante com valores intermediários entre um minimo e um máximo ( como um termômetro de medição que emite valores diversos, não se atendo somente a 0 ou 100). Em uma CLP, esses sinais são cruciais na decisão do tipo de entrada e saída que irá ocorrer.

- Backplane ou Rack com fonte de alimentação

O RACK têm a função de interconetar todas as partes da CLP e permitir a alimentação e comunição entre elas, ele fornece montagem física para as In/Out (entradas e saídas) e conexão eletrica dos barramentos entre modulos(barramentos de dados que estabelecem um link de comunicação entre todos os modulos de In/Out AAbaixo pode-se ver um RACK com expansão e logo abaixo um Rack com CPU;

- Cartão de Entradas e Saidas (In/Out)

O Cartão de entradas é qualquer coisa que possa permitir a entrada de um sinal ao CLP e permitir a execução do programa, podendo ser de sinal analogico ou digital

- veja um exemplo abaixo:

As Saídas tambem podem ser de sinais analogicos ou digitais: ao se ter uma entrada analogica ela vai converter o sinal para digital que ao ser processado será enviado para um cartão de saida analogica que transformara esse sinal em analogico ou vice versa. eles servem para fazer acionamento simples como ligar lampadas ou valvulas etc.

- veja um esquema de entradas e saidas abaixo:

- CPU

É basicamente o cerebro da CLP e atua em quatro modos: Programação, Run, Stop e Reset

- No modo Programação a CPU faz o carregamneto da logica do programa desenvolvido por uma pessoa

- Após entra em modo Run em que está completamente operante com as funções do programa

- No modo Stop a CPU está parada e náo opera, desligando todas as saidas e checando as entradas

- No modo Reset a CPU é reiniciada para as configurações iniciais, caso seja feito sem eliminar os dados registrados é chamado de Warm Reset, caso os dados sejam apagados é chamado de Cold Reset

- Programa

é desenvolvido por uma pessoa em um computador proprio para CLP, a maioria das CLPs usa a linguagem Ladder, desenvolvida para facilitar a programação. O programa define oque será feito pela CLP

- Referencias

- https://alfacompbrasil.com/2019/02/11/clp-o-que-e-e-como-funciona/

- https://www.citisystems.com.br/clp/

- https://www.youtube.com/watch?v=RnYqTpuLWAA

- http://saladaautomacao.com.br/clp/

- https://www.saladaeletrica.com.br/o-que-e-clp/

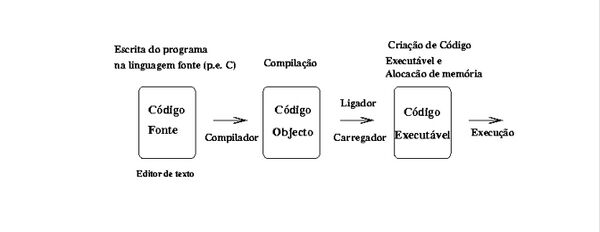

Compiladores

Definição

- O que são compiladores ?

Um compilador nada mais é que uma aplicação com a função traduzir programas. Basicamente ele pega programa desenvolvido em uma linguagem de alto nível e o transforma em seu correspondente em baixo nível.

Um compilador é um software complexo, que cumpre o papel de traduzir, converter e ligar um programa escrito em linguagem de programação ou linguagem fonte em um programa de linguagem de máquina ou linguagem objeto. Ou seja, converte um programa escrito em linguagem de programação para uma linguagem cuja o computador entenda. No início, os compiladores não traduziam diretamente a linguagem fonte para a linguagem objeto, fazendo-se necessária a tradução em uma linguagem simbólica (Assembly), para que a partir de tal seja feita a tradução em linguagem objeto. Concluímos então que os compiladores são de suma importância nos tempos atuais, sabendo que cada vez mais há o estreitar da relação homem/máquina, sendo os compiladores hoje, peça fundamental de diálogo e aprimoramento das tecnologias que surgem atualmente.

- Referências:

- Santos ,Pedro Reis; Langlois ,Thibault. Compiladores - da teoria à prática. 1° edição, FCA editora, 2014.

- https://www.dicio.com.br/compilador/

- http://www.dca.fee.unicamp.br/~eleri/ea876/04/cap3.pdf

- http://producao.virtual.ufpb.br/books/tautologico/compiladores-livro/livro/livro.pdf

Criptografia

- Conceito

- Ferramenta de segurança digital utilizada em programação com o objetivo de proteger as informações de um arquivo. Tal instrumento de proteção garante quase por completo o bloqueio do acesso de terceiros ou usuários indesejados. Outrossim, o termo criptografia não é recente, pois surgiu na Grécia Antiga, kryptós (oculto/escondido) e gráphein (escrita/textos). Porém, como toda sociedade evolui e moderniza, tanto o instrumento como a sua definição passou por aprimoramento, portanto, a preservação de dados é crucial nos dias atuais.

- Tipos de Criptografia

- Criptografia Simples (SSL)

- Programa de proteção simples que garante a validação de medidas de segurança de um domínio, tal programa é recomendado para todo site mesmo que próprio não armazene dados do usuário. A maneira mais fácil de reconhecer se o site utiliza o SSL é procurar pelo ícone de um cadeado verde ao lado da URL, isso significa, criptografia simples ativa.

- Criptografia de Validação Estendida (SSL EV)

- Uma versão aprimorada do SSL extremamente recomendada para sites de comércio eletrônico.

- Certificado WildCard

- Diferente do SSL o WildCard protege não só o domínio principal, como também os sub-domínios em um só certificado. Essa criptografia é destinada a administradores de várias páginas ou sites.

- Certificado Multidomínio (MDC)

- Direcionado para empresas que possuem diversos domínios, pois o MDC assegura a defesa digital de até 210 domínios em um só certificado (SSL), sobretudo, todos são validados com HTTPS.

- Certificado Multidomínio EV (MDC EV)

- Uma versão aprimorada do MDC com enfoque na razão social da empresa.

- Certificado Multidomínio SAN (UCC)

- O UCC funciona apenas para aplicações Microsoft, no mais, não há diferenças notórias em relação a certificado de proteção.

- Certificado CodeSigning

- Criptografia voltada para a assinatura digital dos desenvolvedores/programadores no código fonte do software. Tal certificado assegura o projeto do desenvolvedor, pois é protegido contra edições e compartilhamentos de terceiros. O CodeSignin aceita códigos nos formatos: JAVA, Microsoft, Adobe, IOS, Android e Windows Phone.

- Criptografia para e-mails (S/MIME)

- Assemelha-se ao CodeSigning, no entanto, a ferramenta S/MIME é exclusiva na criptografia e assinatura digital de emails, diferente do item acima que age apenas no código fonte da aplicação. Torna-se imprescindível o uso do S/MIME porque por mais que os servidores possuam certificados digitais, criptografia de ponta, hackers ainda podem invadir o banco de dados e interceptar mensagens, consequentemente, um email sem proteção pode facilmente ser adulterado ou ter um conteúdo sigiloso vazado/exposto. Portanto, toda medida de segurança é viável, no segmento tecnológico programação quanto mais barreiras forem construídas mais protegido estará o sistema, código ou email.

- Criptografia simétrica

- Baseia-se na criação de uma chave única de acesso disponibilizada para o público ou grupo privado. Para acessar o conteúdo criptografado basta inserir a key, no entanto, há uma falha na criptografia simétrica na geração de chaves na proporção do número de visualizadores. Além disso, essa ferramente não verifica a integridade da identidade do usuário abrindo margem para ataques hackers. Portanto, mesmo que haja quebra de sigilo basta gerar outra chave, porém como foi mencionado é uma criptografia não recomendada.

- Criptografia assimétrica

- Opera em torno de duas chaves de acesso, uma chave específica para cifração e outra para decifração, uma key não é gerada a partir de outra, senão será uma criptografia simétrica. A cifração é pública, porém a privada é extremamente restrita para decifrar o código, sendo gerenciada apenas por um seleto grupo. Ademais, a autenticidade é um mecanismo presente nessa ferramenta, possibilitando a exclusividade de apenas uma chave de acesso por pessoa.

- Hashing

- É um algoritmo matemático que transforma qualquer bloco de dados em uma série de caracteres de comprimento fixo. Independentemente do comprimento dos dados de entrada, o mesmo tipo de hash de saída será sempre um valor hash do mesmo comprimento. Cada caractere da senha será modificado por outro caractere do corpo da hash. Ademais, há um fato curioso: as hashs podem ser lidas ou identificadas em cadeias para determinar a integridade do arquivo e se possui certificados ativos, exemplificando, em março de 2014, o DropBox bloqueou o compartilhamento de um determinado arquivo protegido, na época foi questionada por estar violando a privacidade dos usuários, todavia não houve invasão de privacidade, mas sim a leitura da hash no banco de dados. Mediante isso, pôde analisar os certificados de proteção ativos naquele determinado arquivo.

- Criptografia Simples (SSL)

- Como Criptografar?

- Há duas opções mais comuns de criptografar. Primeira, usar ferramentas já existentes criada por um programador, como por exemplo, FlashCrypt, AxCrypt, DiskCryptor,Gpg4win, 7-Zip e várias outras disponíveis na surface web. Essas ferramentas gerarão chaves de acesso para abrir o arquivo desejado (imagens, documentos, vídeos, pdfs, etc). Lembrando que, toda vez que o arquivo for aberto será solicitado a key. Segundo, criar o próprio mecanismo de proteção usando a linguagem que julgar melhor, desde que, haja no mínimo 128 bits nas keys. Portanto, criptografia não é uma funcionalidade incomum, tampouco irrelevante, pelo contrário, é um instrumento digital extremamente necessário nos dias de hoje, principalmente para usuários comuns porque realizam transferência de dados importantes em vias públicas de acesso sem proteção alguma.

- Referências bibliográficas

- https://www.kaspersky.com.br/resource-center/definitions/encryption

- https://www.devmedia.com.br/criptografia-conceito-e-aplicacoes-revista-easy-net-magazine-27/26761

- https://it-eam.com/criptografia-de-dados-por-que-e-tao-relevante-para-sua-empresa/

- https://www.isbrasil.info/blog/8-tipos-de-criptografia-que-voce-precisa-conhecer.html

- https://www.hostinger.com.br/tutoriais/como-funciona-o-ssh/#Entendendo-diferentes-tecnicas-de-criptografia

- https://dual.studio/certificados.php

- https://alphaservers.com.br/whmcs/index.php?rp=/store/ssl-certificates/wildcard

- https://www.rapidssl.com.br/certificado-code-signing

- https://www.globalsign.com/pt-br/blog/o-que-e-smime/

- https://docs.microsoft.com/pt-br/office365/securitycompliance/s-mime-for-message-signing-and-encryption

- https://www.segurisoft.com.br/criptografia/top-10-software-criptografia/

- https://www.devmedia.com.br/como-funciona-a-criptografia-hash-em-java/31139

- https://cryptoid.com.br/banco-de-noticias/29196criptografia-simetrica-e-assimetrica/

- https://blog.validcertificadora.com.br/assinatura-digital-e-hash-sao-mesma-coisa/

Data Mining

- O que é?

Data mining, ou mineração de dados, é a prática de examinar dados que já foram coletados – utilizando diversos tipos de algoritmos, normalmente de forma automática –, a fim de gerar novas informações e encontrar padrões. Considerando que minerar dados é um processo de transformar dados em informações úteis (dados mais valiosos a partir de dados complexos). Para atingir esse objetivo, alguns passos são realizados, como: encontrar padrões, associações e anomalias gerais nos dados. Em data mining não importa a forma como os dados foram coletados, se via banco de dados, 'web scraping', API's, etc.

- Técnicas no Data Mining

O Data Mining (DM) descende fundamentalmente de 3 linhagens. A mais antiga delas é a estatística clássica. Sem a estatística não seria possível termos o DM, visto que a mesma é a base da maioria das tecnologias a partir das quais o DM é construído.

A segunda linhagem do DM é a Inteligência Artificial (IA). Essa disciplina, que é construída a partir dos fundamentos da heurística, em oposto à estatística, tenta imitar a maneira como o homem pensa na resolução dos problemas estatísticos.

E a terceira e última linhagem do DM é a chamada machine learning, que pode ser melhor descrita como o casamento entre a estatística e a Inteligência Artificial. Enquanto a Inteligência Artificial não se transformava em sucesso comercial, suas técnicas foram sendo largamente cooptadas pela machine learning, que foi capaz de se valer das sempre crescentes taxas de preço/performance oferecidas pelos computadores nos anos 80 e 90, conseguindo mais e mais aplicações devido às suas combinações entre heurística e análise estatística. Machine learning é uma disciplina científica que se preocupa com o design e desenvolvimento de algoritmos que permitem que os computadores aprendam com base em dados, como a partir de dados do sensor ou bancos de dados. Um dos principais focos da Machine Learnig é automatizar o aprendizado para reconhecer padrões complexos e tomar decisões inteligentes baseadas em dados.

- Informações obtidas pelo Data Mining

- Associações: São ocorrências ligadas a um único evento. Por exemplo:um estudos de modelos de compra em supermercados pode revelar que, na compra de salgadinhos de milho, compra-se também um refrigerante tipo cola em 65% das vezes: mas, quando há uma promoção, o refrigerante é comprado em 85% das vezes.Com essas informações, os gerentes podem tomar decisões mais acertadas pois aprenderam a respeito da rentabilidade de uma promoção.

- Sequências: Na sequência os eventos estão ligados ao longo do tempo. Pode-se descobrir, por exemplo, que quando se compra uma casa, em 65% as vezes se adquire uma nova geladeira no período de duas semanas; e que em 45% das vezes, um fogão também é comprado um mês após a compra da residência.

- Classificação: Reconhece modelos que descrevem o grupo ao qual o item pertence por meio do exame dos itens já classificados e pela inferência de um conjunto de regras. Exemplo: empresas de operadoras de cartões de crédito e companhias telefônicas preocupam-se com a perda de clientes regulares, a classificação pode ajudar a descobrir as características de clientes que provavelmente virão abandona-las e oferecer um modelo para ajudar os gerentes a prever quem são, de modo que se elabore antecipadamente campanhas especiais para reter esses clientes.

- Aglomeração (clustering): Funciona de maneira semelhante a classificação quando ainda não foram definidos grupos. Uma ferramenta de data mining descobrirá diferentes agrupamentos dentro da massa de dados. Por exemplo ao encontrar grupos de afinidades para cartões bancários ou ao dividir o banco de dados em categorias de clientes com base na demografia e em investimentos pessoais.

- Prognóstico: Embora todas essas aplicações envolvam previsões, os prognósticos as utilizam de modo diferente. Partem de uma série de valores existentes para prever quais serão os outros valores. Por exemplo um prognóstico pode descobrir padrões nos dados que ajudam os gerentes a estimar o valor futuro de variáveis com números de vendas.

- Ramificações

O Data Mining é um campo que compreende atualmente muitas ramificações importantes. Cada tipo de tecnologia tem suas próprias vantagens e desvantagens, do mesmo modo que nenhuma ferramenta consegue atender todas as necessidades em todas as aplicações. Algumas das ramificações do Data Mining são:

- Redes neurais: são sistemas computacionais baseados numa aproximação à computação baseada em ligações. Nós simples (ou "neurões", "neurônios", "processadores" ou "unidades") são interligados para formar uma rede de nós - daí o termo "rede neural". A inspiração original para esta técnica advém do exame das estruturas do cérebro, em particular do exame de neurônios. Exemplos de ferramentas: SPSS Neural Connection, IBM Neural Network Utility, NeuralWare NeuralWork Predict.

- Indução de regras: a Indução de Regras, ou Rule Induction, refere-se à detecção de tendências dentro de grupos de dados, ou de “regras” sobre o dado. As regras são, então, apresentadas aos usuários como uma lista “não encomendada”. Exemplos de ferramentas: IDIS da Information Discovey e Knowledge Seeker da Angoss Software.

- Árvores de decisão: baseiam-se numa análise que trabalha testando automaticamente todos os valores do dado para identificar aqueles que são fortemente associados com os itens de saída selecionados para exame. Os valores que são encontrados com forte associação são os prognósticos chaves ou fatores explicativos, usualmente chamados de regras sobre o dado. Exemplos de ferramentas: Alice d’Isoft, Business Objects BusinessMiner, DataMind.

- Analise de séries temporais: a estatística é a mais antiga tecnologia em DM, e é parte da fundação básica de todas as outras tecnologias. Ela incorpora um envolvimento muito forte do usuário, exigindo engenheiros experientes, para construir modelos que descrevem o comportamento do dado através dos métodos clássicos de matemática. Interpretar os resultados dos modelos requer “expertise” especializada. O uso de técnicas de estatística também requer um trabalho muito forte de máquinas/engenheiros. A análise de séries temporais é um exemplo disso, apesar de freqüentemente ser confundida como um gênero mais simples de DM chamado “forecasting” (previsão). Exemplos de ferramentas: S+, SAS, SPSS.

- Visualização: mapeia o dado sendo minerado de acordo com dimensões especificadas. Nenhuma análise é executada pelo programa de DM além de manipulação estatística básica. O usuário, então, interpreta o dado enquanto olha para o monitor. O analista pode pesquisar a ferramenta depois para obter diferentes visões ou outras dimensões. Exemplos de ferramentas: IBM Parallel Visual Explorer, SAS System, Advenced Visual Systems (AVS) Express - Visualization Edition.

- Sitografia

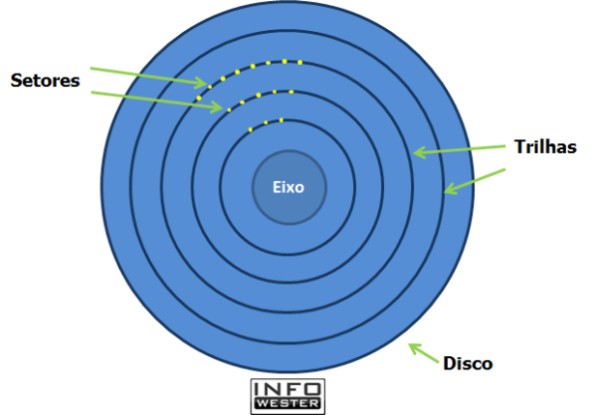

Disco Rígido

- Conceito

- O disco rígido, ou HD (Hard Disk), é o dispositivo de armazenamento permanente de dados mais utilizado nos computadores. Nele, são armazenados desde os seus arquivos pessoais até informações utilizadas exclusivamente pelo sistema operacional.

- O disco rígido não é um tipo dispositivo de armazenamento novo, mas sim um aparelho que evoluiu com o passar do tempo.

- Componentes e funcionamento

- Placa lógica

- A placa lógica reúne componentes responsáveis por diversaas tarefas. Um deles é um chip conhecido como controlador, que gerencia uma série de ações, como a movimentação dos discos e das cabeças de leitura/gravação, o envio e recebimento de dados entre os discos e o computador, e até rotinas de segurança.

- Outro dispositivo comum à placa lógiva é um pequeno chip de memória conhecido como buffer, visto mais abaixo. Cbe a ele a tarefa de armazenar pequenas quantidades de dados durante a comunicação com o computador.

- Discos

- Pratos e eixo : os pratos são os discos onde os dados são armazenados. Eles são feitos, geralmente, de alumínio recoberto por um material magnético e por uma camada de material protetor. Quanto mais denso for o material magnético, maior é a capacidade de armazenamento do disco. Os discos ficam posicionados sob um eixo responsável por fazê-los girar. É comum encontrar HDs que giram a 7.200 RPM, mas também há modelos que alcançam a taxa de 10.000 rotações.

- Cabeça e braço: os HDs contam com um dispositivo chamado cabeça de leitura e gravação. Trata-se de um item de tamanho bastante reduzido que contém uma bobina que utiliza impulsos magnéticos pra manipular as moléculas da superfície do disco e assim gravar dados. A cabeça é localizada na ponta de um dispositivo denominado braço, que tem a função de posicionar os cabeçotes acima da superfície dos pratos.

- Atuador: é o responsável por mover o braço acima da superfície dos pratos e assim permitir que as cabeças façam o seu trabalho. O trabalho entre esses componentes precisa ser bem feito. O simples fato de a cabeça de leitura e gravação encostar na superfície de um prato é suficiente para causar danos a ambos.

- Gravação e leitura de dados

- A superfície de gravação dos pratos é composta por materiais sensíveis ao magnetismo (geralmente, óxido de ferro). O cabeçote de leitura e gravação manipula as moléculas deste material por meio de seus polos. Para isso, a polaridade das cabeças muda em uma frequência muito alta: quando está positiva, atrai o polo negativo das moléculas e vice-versa. De acordo com esta polaridade é que são gravados os bits (0 e 1). No processo de leitura de dados, o cabeçote simplesmente "lê" o campo magnético gerado pelas moléculas e gera uma corrente elétrica correspondente, cuja variação é analisada pelo controlador do HD para determinar os bits. Para a "ordenação" dos dados no HD, é utilizado um esquema conhecido como geometria dos discos. Nele, o disco é "dividido" em cilindros, trilhas e setores:

- As trilhas são círculos que começam no centro do disco e vão até sua borda, como se estivessem um dentro do outro. Cada trilha é dividida em trechos regulares chamados de setores. Cada setor possui uma capacidade determinada de armazenamento (geralmente, 512 bytes).

- HDs externos

- É possível encontrar vários tipos de HDs no mercado, desde os conhecidos discos rígidos para instalação em desktops, passando por dispositivos mais sofisticados voltados ao mercado profissional (ou seja, para servidores), chegando aos cada vez mais populares HDs externos.

- HD externo simplesmente é um HD que você pode levar para praticamente qualquer lugar e conectá-lo ao computador somente quando precisar. Para isso, pode-se usar, por exemplo, portas USB, FireWire e até SATA externo, tudo depende do modelo do HD.

- referências bibliográficas:

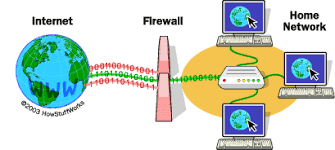

DNS

- Definição

- DNS é a abreviação de Domain Name System (Sistema de Nome de Domínios). Sua função é interligar um domínio (o nome de um site como google.com, por exemplo) e um número de IP (uma sequência numérica como 210.128.0.23, por exemplo), que é a identificação do servidor correspondente ao domínio.

Criado na década de 80 para permitir a expansão das redes de computadores baseadas em TCP/IP, esse sistema subtituiu a rede antes utilizada chamada ARPANET. Esta Rede possuía um único arquivo de texto contendo uma tabela que relacionava os domínios com seus respectivos IPs. Porém, essa rede se tornou inviável à medida que mais e mais computadores entravam para a rede, pois a manutenção e atualização desse arquivo se mostraram trabalhosas.

- Diferente de sua antecessora, o DNS possui vários servidores com cópias dos arquivos distribuídos pelo mundo, cada um com uma cópia do enorme banco de dados de IPs registrados. O DNS traduz o domínio pelo qual o usuário procura na barra de endereços para números de IP.

- Como Funciona

- O banco de dados do DNS é organizado de forma hierárquica. Inicialmente, temo o chamado servidor raiz (root server). Este é automaticamente o principal serviço de DNS. Sua representação pode ser observada sempre que existe um ponto final no endereço, como no domínio www.google.com. Mas não é necessária a digitação desse ponto, uma vez que o sistema já reconhece o domínio mesmo não os introduzindo. A internet mundial possui 13 root servers no mundo todo. Assim, se um servidor parar, os outros manterão a estabilidade da função. Logo após o tipo “raiz”, vem o domínio de alto nível (Top Domain Level/TDL), sendo representado pelos servidores que abrigam os sites com final “.gov, .edu, .org, .net, .com, .br, .uk etc”. O tipo “com autoridade” é o último deles e, como o nome supõe, esse tipo de servidor DNS é estabelecido para fins próprios.

- Os root servers reconhecem todos os endereços de todos os outros servidores do tipo TDL. O sistema foi dividido dessa forma para evitar que uma falha em algum dos servidores inviabilize as conexões de rede.

- O sistema de DNS é parte fundamental da estrutura da internet, pois é o sistema que interliga o domínio ao seu destino, sem a necessidade de digitar sentenças numéricas extensas (IPs) todas as vezes que se quer buscar por algum endereço.

- Bibliografia

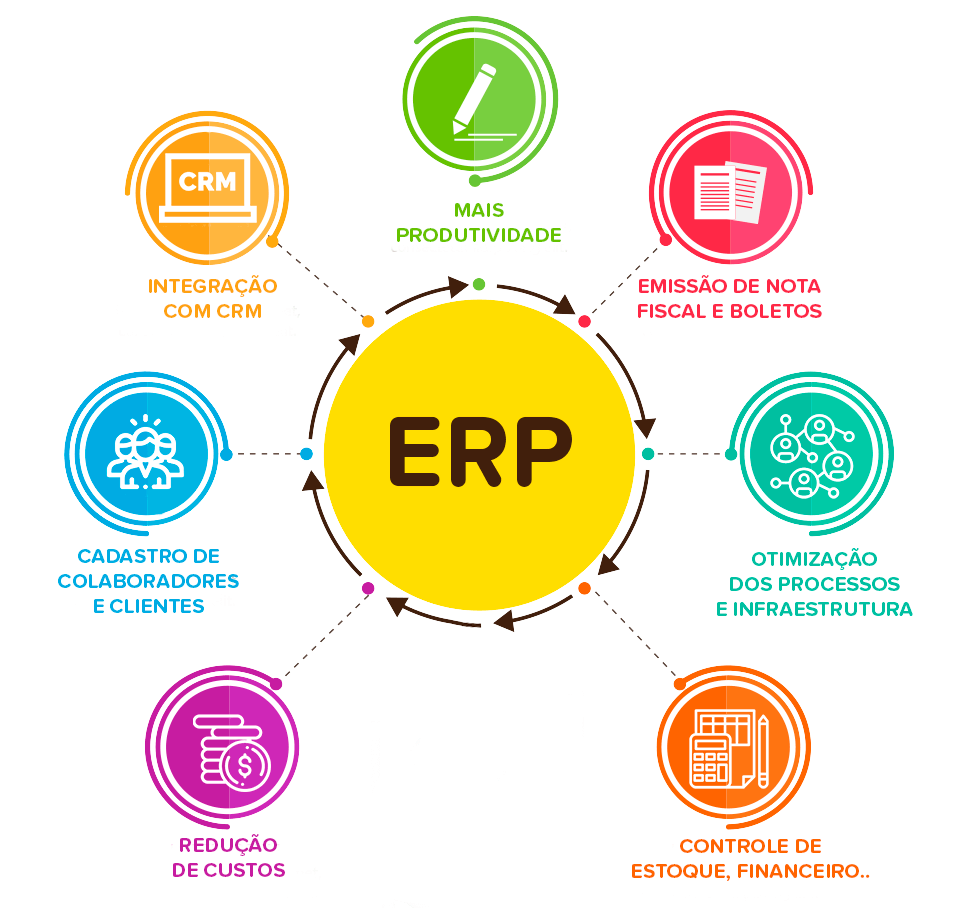

ERP

O que é?

- De forma geral, o ERP(Enterprise Resource Planning ou Planejamento dos Recursos da Empresa) representa uma série de atividades gerenciadas por um software ou por pessoas, que ajudam na gestão de processos dentro de uma empresa. Portanto, ERP é um Sistema de Gestão Empresarial.

- Uma das principais características dos sistemas ERP é justamente serem sistemas integrados, que permitem interligar e coordenar as atividades internas da empresa.

Alguns impactos nas empresas:

- A adoção de sistemas ERP transforma a empresa em pelo menos três maneiras:

- A terceirização do desenvolvimento de aplicações transacionais, reduzindo custos de informática;

- A implementação de um modelo de empresa integrada e centralizada;

- E a mudança da visão departamental para a visão de processos, por meio dos modelos disponibilizados pelo sistema.

Vantagens e desvantagens:

- PACOTE COMERCIAL:

- Pontos positivos nos aspectos organizacionais:

- Foco na atividade principal da empresa;

- Possibilitar a reorganização dos processos, utilizando informações de outras empresas acumuladas no sistema;

- Redução dos custos de informática;

- Foco por parte da Tecnologia da Informação para soluções empresariais, alterando o foco no desenvolvimento de sistemas.

- Pontos negativos:

- Dependência do fornecedor;

- Problemas de adaptação do pacote à empresa;

- Necessidade de alterar os processos da empresa;

- Necessidade de utilização de consultoria para implementação;

- Resistência a mudanças;

- Tempo para adaptação às interfaces desenvolvidas não especificas para a empresa;

- Possíveis incompartibilidade entre a estratégia da empresa e a lógica do ERP.

- Pontos positivos nos aspectos tecnológicos:

- Atualização de tecnologia;

- Contar com ganho de escala na pesquisa de novas tecnologias;

- Ganho de escala no tempo para desenvolvimento do sistema;

- Redução do backlog de aplicações;

- Ganho de uma infra-estrutura pela qual torna-se possível desenvolver os sistemas que a empresa precisa para diferenciar-se.

- Pontos negativos:

- Falta de controle sobre a evolução tecnológica do sistema;

- O conhecimento a respeito do funcionamento do pacote não está na empresa;

- Grandes mudanças no modelo de desenvolvimento e necessidades da equipe de TI, sendo necessário um retreinamento;

- Desafios em manter todo o conhecimento a respeito do funcionamento do pacote após a implementação;

- Nem todas as necessidades da empresa estarão disponíveis no pacote, sendo necessária a integração com outros sistemas.

- Pontos positivos nos aspectos organizacionais:

- INTEGRAÇÂO

- Pontos positivos nos aspectos organizacionais:

- Redução de mão-de-obra;

- Disponibilidade de maior controle sobre a operação da empresa, disponbilizado pela integração dos processos;

- Entrada única de informação no sistema;

- Maior velocidade nos processos;

- Aumentar a competitividade da empresa através da integração das atividades;

- Disponibilização online de informações alimentadas no sistema.

- Pontos negativos:

- Mudança cultural da visão departamental para a visão de processos;

- As decisões devem ser tomadas em grupo, visto que todos os departamentos estarão integrados no mesmo sistema;

- Entrada de dados incorretos pode ser imediatamente propagada pelo sistema;

- Altos custos e prazos de implementação.

- Pontos positivos nos aspectos tecnológicos:

- Desfragmentação dos sistemas de informação da empresa;

- Eliminação de interfaces entre sistemas isolados;

- Eliminação da necessidade de manutenção em diversos sistemas isolados e diferentes.

- Pontos negativos:

- Maior preocupação sobre a disponibilidade do sistema, podendo ocasionar uma interdependência entre os módulos;

- Maior dificuldade para fazer a atualização de versões e alterações no sistema, devido à necessidade de acordo entre os departamentos envolvidos.

- Pontos positivos nos aspectos organizacionais:

- ABRANGÊNCIA FUNCIONAL

- Pontos positivos nos aspectos organizacionais:

- Processos e procedimentos padronizados;

- Custos de treinamento reduzidos.

- Pontos negativos:

- Dependência de um único fornecedor em um sistema para o objetivo da empresa.

- Pontos positivos nos aspectos tecnológicos:

- Um único sistema e interface para toda a empresa;

- Redução dos custos de operação.

- Pontos negativos:

- Maior preocupação sobre a disponibilidade do sistema, pelo fato da empresa depender de um único sistema para funcionar.

- Pontos positivos nos aspectos organizacionais:

- BANCO DE DADOS CORPORATIVO

- Pontos positivos nos aspectos organizacionais:

- Padronização de informações;

- Eliminação de produção desnecessária de mesma informação produzida por departamentos distintos;

- Melhoria na qualidade da informação disponibilizada;

- Entrada única de informação no sistema;

- Disponibilização de informações gerenciais para análise de empresa como um todo.

- Pontos negativos:

- Mudança cultural da visão departamental para a visão de processos;

- As decisões devem ser tomadas em grupo, visto que todos os departamentos estarão integrados no mesmo sistema;

- Entrada de dados incorretos pode ser imediatamente propagada pelo sistema.

- Pontos positivos nos aspectos tecnológicos:

- Possibilidade de extrair informações utilizando ferramentas Desktop;

- Eliminação de redundâncias no banco de dados;

- Eliminação de duplicidade de esforços na entrada de dados.

- Pontos negativos:

- Maior dificuldade para fazer atualizações e alterações no sistema devido à necessidade de haver acordo entre todos os departamentos, visto que todos dependem do mesmo sistema para funcionar.

- Pontos positivos nos aspectos organizacionais:

Exemplo:

- Uma empresa precisa gerenciar contas a pagar e a receber, vendas e pedidos, folhas de pagamentos de funcionários, controle de estoque de mercadosrias, entre vários outros processos. Deixando cada processo destes nas mãos de diferentes departamentos, acaba elevando os custos e tempo gasto, além de elevar as chances de surgirem erros. Quando todas essas informações estão dentro de um único sistema, erros são mais difíceis de acontecer e o gerenciamento e análise de todas essas informações ficam mais rápidas e com custos menores. O software ERP serve para isso.

Fontes de pesquisa:

- http://www.scielo.br/pdf/%0D/gp/v9n3/14570.pdf

- http://www.anpad.org.br/admin/pdf/enanpad1999-ai-13.pdf

- http://www.race.nuca.ie.ufrj.br/teses/usp/Souza.pdf

- http://www.scielo.br/pdf/%0D/prod/v15n1/n1a08.pdf

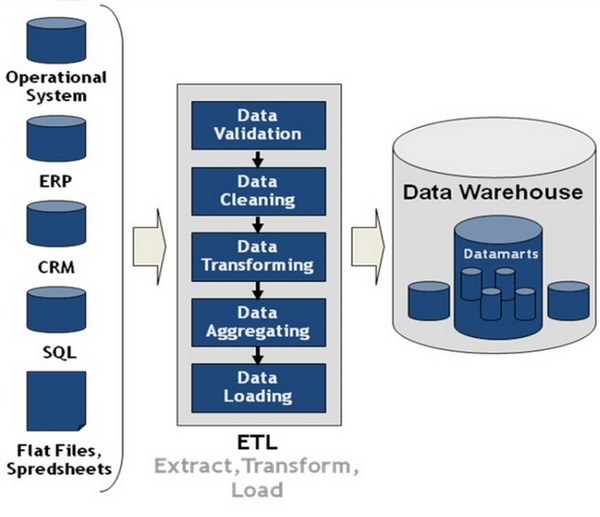

ETL

Conceito e definição.

- ETL (sigla do inglês Extract, Transform and Load - Extrair, Transformar e Carregar) é uma forma de se integrar os dados que consiste em extrair os dados de diversas fontes operacionais, tratar esses dados de maneira consistente para serem consumidos pela equipe OLAP (Online Analytical Processing - ferramentas para elaboração de relatórios) e armazenar essas informações no banco de dados (em data warehouses, para o caso de bancos de dados relacionais ou datalakes para soluções Big Data).

- Extrair o dado é buscá-lo na origem operacional da sua aplicação/projeto. É importante que ele seja consumido da maneira mais pura possível para que, a partir de suas lógicas e padrões, na etapa seguinte você consiga imprimir uma qualidade neste dado.

- As ferramentas de extração do mercado conectam-se a um servidor de banco de dados (Ex.:Oracle) e recebe as informações das ferramentas operacionais e já o estrutura em forma de tabelas (arquivos flat) com um certo padrão específico (com chaves, ordenação, nomeação de campos etc)

- Transformar o dado é organizá-lo, tratá-lo para retirar suas imperfeições e deixá-lo da maneira mais coesa e simples possível para que relatórios confiáveis sejam elaborados a partir deste dado. Ele precisa fazer sentido e ser de fácil compreensão em sua leitura.

- Alguns passos da transformação do dado é a limpeza de imperfeições nos dados e padronização destes, corrigindo formatações erradas, agregando em métricas e indicadores importantes para que as ferramentas visuais OLAP tenham a melhor performance possível.

- Carregar o dado por sua vez consiste em armazená-lo em um bancos de dados de sua escolha. Hoje as soluções são diversas devido as diferentes necessidades de bancos de dados do mercado.

- Dentre as soluções atuais para armazenamento, temos o Big Data em termos não-relacionais ou o Data Warehouse tradicional em seu modelo relacional.

- Referências

eXtreme Programming

- O que é o XP - eXtreme Programming?

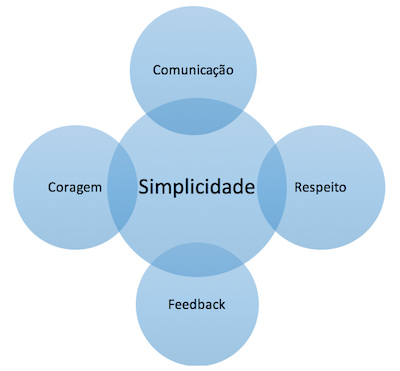

- O eXtreme Programming é uma método ágil de desenvolvimento de software que traz melhor qualidade, menor tempo de desenvolvimento e menores custos. Para a prática desse método devem ser seguidos um conjunto de valores: comunicação, coragem, feedback, respeito e simplicidade.

- Nessa prática o projeto vai sendo entregue ao cliente em pequenos pedaços conforme a sua necessidade, assim podendo ser modificado e melhorado de acordo com o que o mesmo precisa. Isso faz com que o projeto seja mais produtivo já que é organizado de forma simples e eficiente para que a equipe possa junta achar soluções para os problemas propostos.

- De acordo com os valores do XP, os programadores extremos devem sempre estar se comunicando tanto quanto com os outros programadores quanto com o próprio cliente, para do segundo receber o feedback dos testes diários que devem ser feitos. Mantendo o design sempre simples eles devem entregar o projeto ao cliente o mais cedo possível, respeitando as mudanças que cada parte da equipe sugerir e tendo coragem para enfrentar mudanças na codificação, nas tecnologias utilizadas, etc.

- Valores do XP: